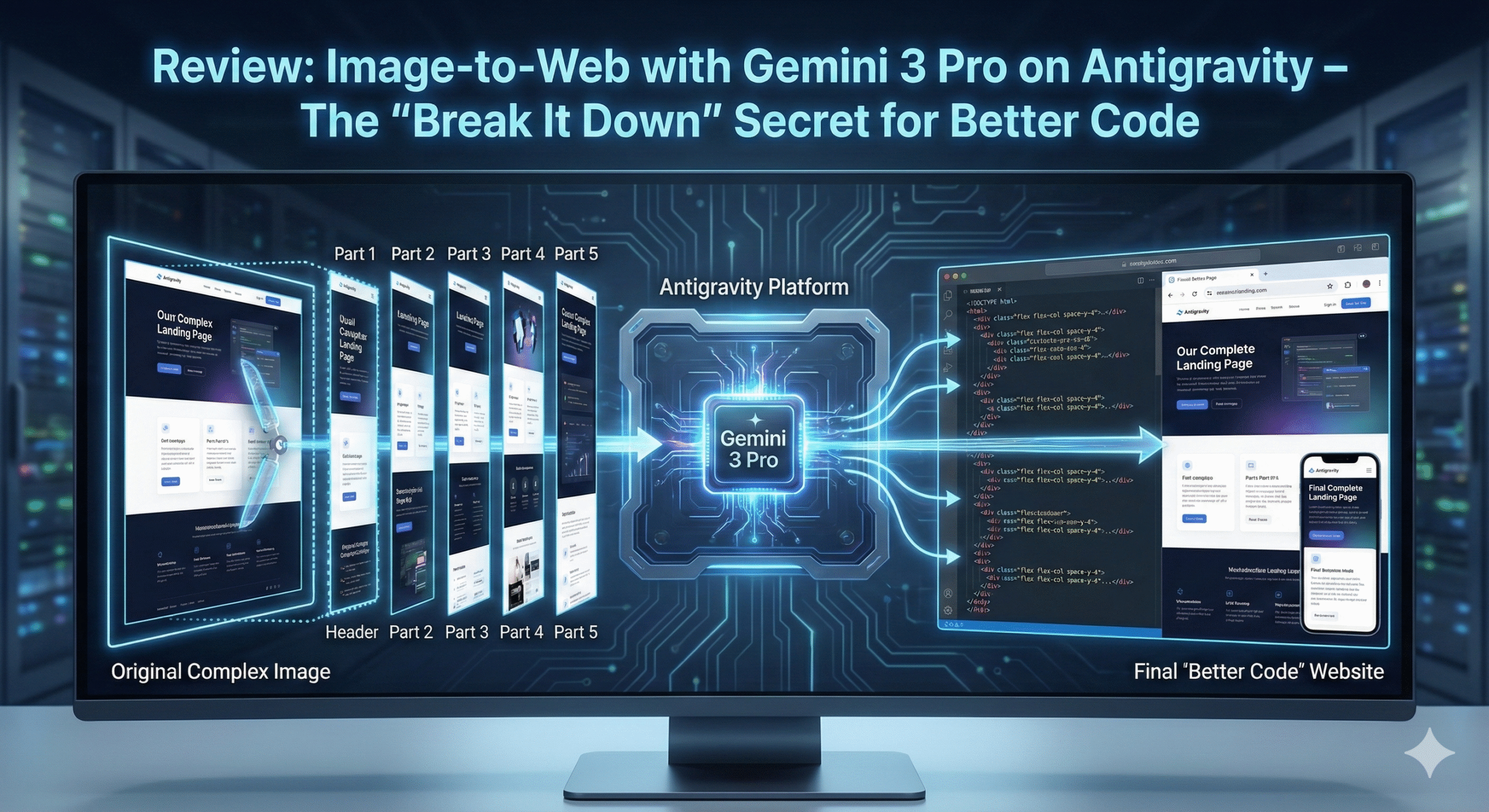

Recently, I had the opportunity to experience the Antigravity Google AI Pro account and decided to challenge the Gemini 3 Pro (High) model with...

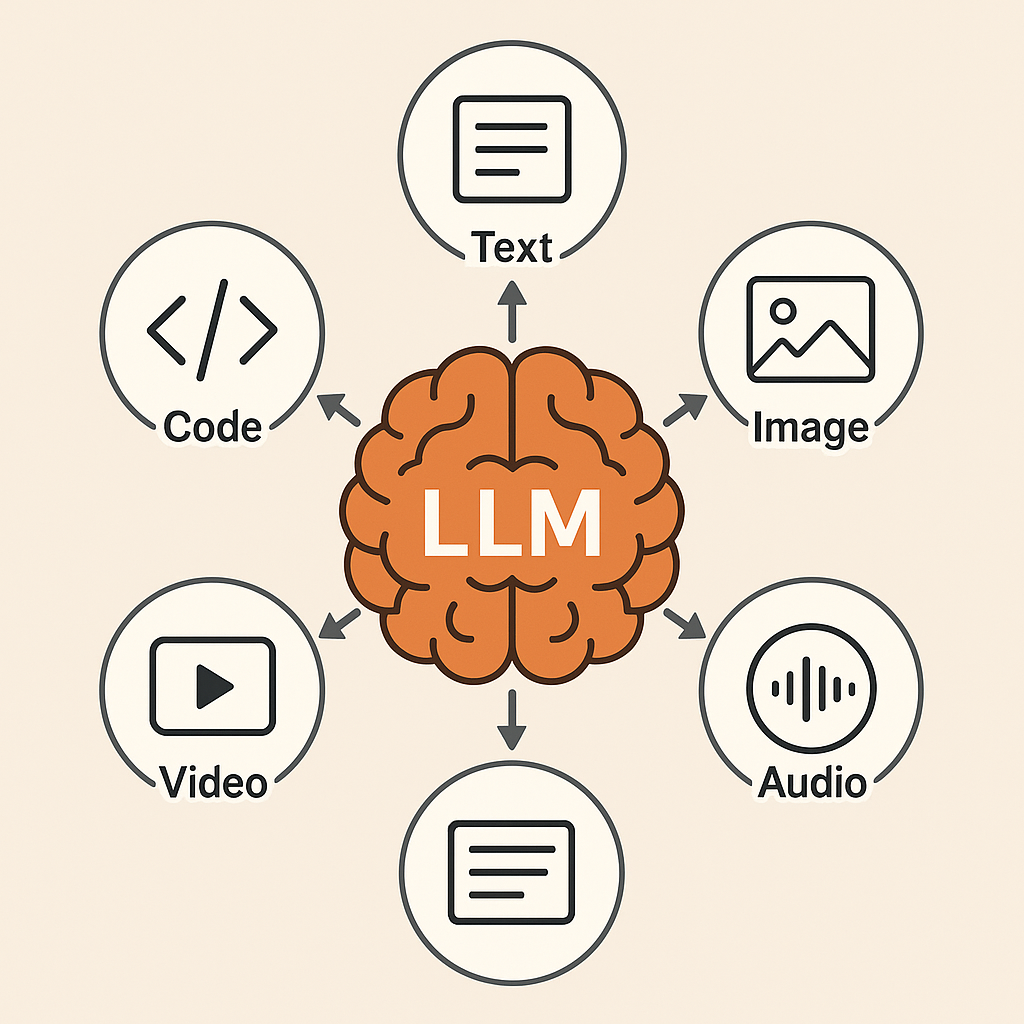

We make services people love by the power of Gen AI.