Bạn đã biết đến RAG (Retrieval Augmented Generation) đang nhận được nhiều sự chú ý trong lĩnh vực AI tạo sinh chưa? RAG là công nghệ mới nhất được thiết kế để nâng cao độ chính xác của các câu trả lời từ LLMs (Mô hình Ngôn ngữ Lớn), và các nhà cung cấp đám mây lớn như AWS và Azure đang thúc đẩy việc triển khai nó. Bằng cách hiểu về cơ chế của RAG, có thể tạo ra các câu trả lời chất lượng cao hơn cả ChatGPT. Bài viết này sẽ giải thích chi tiết về cơ chế cơ bản của RAG, các ứng dụng cụ thể và các ví dụ.

Tổng quan về RAG

Nguyên lý cơ bản của RAG

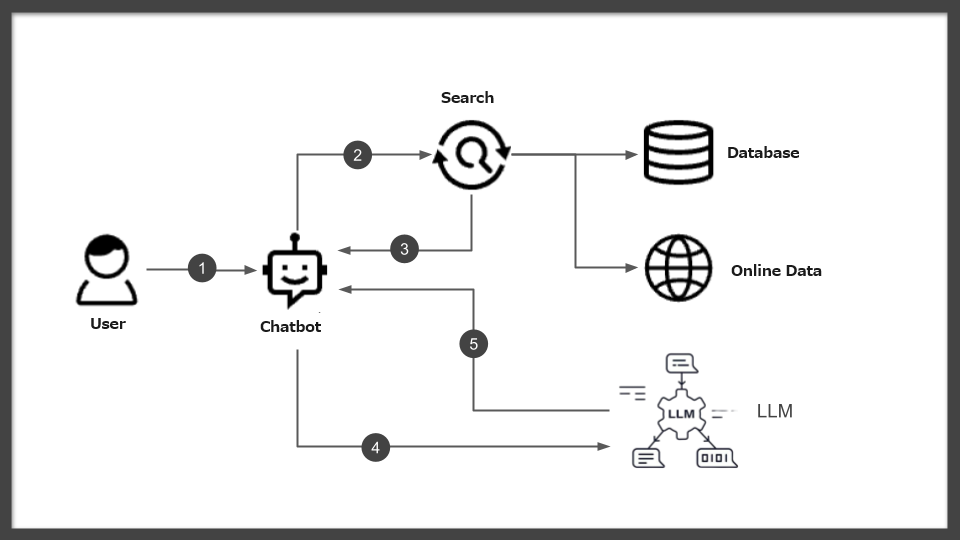

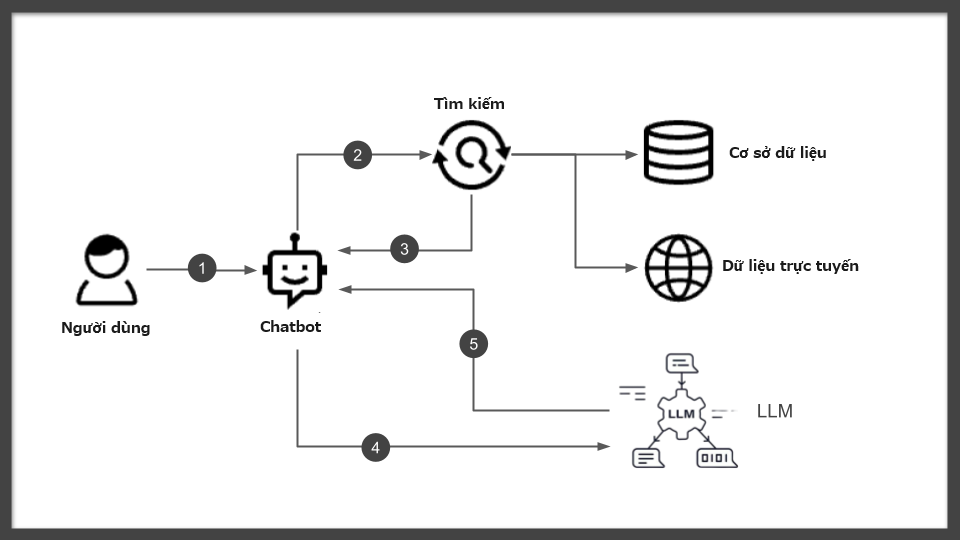

RAG (Retrieval Augmented Generation) là một công nghệ đột phá, nâng cao đáng kể độ chính xác của các phản hồi từ AI tạo sinh. Công nghệ này dựa trên một cơ chế độc đáo, cải thiện chất lượng câu trả lời do Các Mô hình Ngôn ngữ Lớn (LLMs) cung cấp bằng cách khéo léo kết hợp thông tin từ các cơ sở dữ liệu và cơ sở kiến thức bên ngoài.

Cụ thể, đối với các câu hỏi từ người dùng, RAG tìm kiếm động các thông tin bên ngoài liên quan và tái cấu trúc câu trả lời dựa trên thông tin này. Qua quá trình này, AI tạo sinh có thể cung cấp các câu trả lời chính xác hơn, đôi khi dựa trên thông tin mới nhất.

Chẳng hạn, AWS sử dụng công nghệ sáng tạo này để dựa vào dữ liệu và sự kiện cụ thể để phản hồi các mô hình như ChatGPT. Trong các dịch vụ của Azure, RAG được sử dụng để tạo ra các câu trả lời tùy chỉnh dựa trên kiến thức cụ thể của doanh nghiệp. Hơn nữa, Oracle cũng đã triển khai RAG để cải thiện đáng kể độ chính xác của các câu trả lời cho các câu hỏi đặc thù của doanh nghiệp.

Như các ví dụ cho thấy, RAG tối đa hóa tiềm năng của AI tạo sinh và LLMs, mở rộng đáng kể phạm vi và độ chính xác của các câu trả lời của chúng. Đáng chú ý, RAG đã trở thành công nghệ dễ tiếp cận hơn cho các nhà phát triển rộng rãi thông qua các nền tảng lớn như AWS và Azure. Điều này khiến RAG trở thành công nghệ đầy hứa hẹn và hấp dẫn đối với các kỹ sư có kinh nghiệm phát triển với API của ChatGPT hoặc Azure OpenAI Service.

Các yếu tố kỹ thuật và chức năng chính của RAG

Các yếu tố kỹ thuật cốt lõi của RAG (Retrieval Augmented Generation) nằm ở cơ chế tìm kiếm và tích hợp thông tin bên ngoài. Công nghệ đổi mới này nâng cao đáng kể chất lượng của các phản hồi được tạo ra bởi AI bằng cách xác định thông tin có liên quan nhất đối với một truy vấn cụ thể và khéo léo tích hợp nó vào hệ thống kiến thức của LLM (Mô hình Ngôn ngữ Lớn). Chức năng của RAG bao gồm việc cải thiện độ chính xác và kịp thời của thông tin, điều này làm cho các phản hồi mà nó tạo ra trở nên cụ thể và đáng tin cậy hơn.

Một vai trò đáng chú ý của RAG là khả năng mở rộng cơ sở kiến thức hiện có của LLM và làm cho các nguồn thông tin mới có sẵn. Ví dụ, AWS sử dụng RAG để trích xuất thông tin mới nhất từ các cơ sở dữ liệu dựa trên đám mây, và Azure sử dụng nó để tạo ra các phản hồi tùy chỉnh trong sự hợp tác với các cơ sở kiến thức đặc thù của công ty. Hơn nữa, Oracle sử dụng RAG để cung cấp các câu trả lời chuyên biệt cho các ngành hoặc lĩnh vực nhất định, từ đó mở rộng đáng kể khả năng áp dụng của AI tạo sinh.

Thêm vào đó, RAG có khả năng cải thiện đáng kể các tiêu chí quan trọng cho AI tạo sinh, như độ chính xác và liên quan của các phản hồi. Điều này là bởi vì AI tạo sinh tích cực sử dụng thông tin bên ngoài, không chỉ sở hữu kiến thức rộng lớn mà còn phát triển khả năng chọn lọc và điều chỉnh các phản hồi phù hợp nhất đối với các truy vấn cụ thể.

Như vậy, RAG cung cấp các yếu tố kỹ thuật và chức năng đổi mới cho AI tạo sinh và LLMs, cho phép các khả năng xử lý ngôn ngữ tự nhiên tiên tiến hơn và khả năng tạo phản hồi linh hoạt phù hợp với nhu cầu cá nhân. Điều này cho phép các kỹ sư phát triển các hệ thống tinh vi hơn trong khi hợp tác với các API hiện có như ChatGPT và Azure OpenAI Service.

Các ví dụ ứng dụng của công nghệ RAG

Giới thiệu ứng dụng theo từng ngành

Phạm vi ứng dụng của công nghệ RAG (Retrieval Augmented Generation) rộng lớn, và lợi ích của nó đang được nhận thức ngày càng rộng rãi trong nhiều ngành khác nhau. Công nghệ này cho phép cung cấp các câu trả lời tùy chỉnh phù hợp với các ngành và nhu cầu cụ thể bằng cách kết hợp khả năng của AI tạo sinh và LLMs (Mô hình Ngôn ngữ Lớn). Việc kết hợp kiến thức chuyên môn của từng ngành và tạo ra các câu trả lời chất lượng cao dựa trên thông tin đó là chức năng quan trọng của RAG.

Ví dụ, trong ngành y tế, RAG được sử dụng để cung cấp thông tin về các phát hiện nghiên cứu và phương pháp điều trị mới nhất cho bệnh nhân và nhân viên y tế. RAG có thể tìm thấy thông tin phù hợp từ các cơ sở dữ liệu y tế lớn và tích hợp nó vào LLMs để tạo ra các câu trả lời chi tiết và chính xác về các triệu chứng và bệnh cụ thể.

Trong lĩnh vực tài chính, RAG được sử dụng để cung cấp cho khách hàng thông tin mới nhất về xu hướng thị trường và các sản phẩm tài chính. Nó nhanh chóng kết hợp dữ liệu thị trường và xu hướng cụ thể, cho phép cung cấp các câu trả lời kịp thời và chính xác cho các yêu cầu của khách hàng.

Hơn nữa, trong lĩnh vực hỗ trợ khách hàng, RAG hữu ích trong việc quản lý các câu hỏi thường gặp và thông tin khắc phục sự cố liên quan đến sản phẩm và dịch vụ, cung cấp các câu trả lời chính xác cho các yêu cầu cụ thể của khách hàng. Điều này góp phần cải thiện sự hài lòng của khách hàng và hiệu quả hoạt động hỗ trợ.

Những ví dụ này cho thấy RAG mở rộng khả năng ứng dụng của AI tạo sinh và phục vụ như một công cụ có giá trị trong việc cung cấp các giải pháp cho các ngành và vấn đề cụ thể. Các kỹ sư được kỳ vọng sẽ xây dựng các cơ chế RAG phù hợp với nhu cầu đặc thù của ngành sử dụng các API hiện có như ChatGPT và Azure OpenAI Service, nhằm mục tiêu cung cấp dịch vụ chất lượng cao hơn.

Các ứng dụng thành công của RAG

Công nghệ RAG (Retrieval-Augmented Generation) đã mở rộng đáng kể phạm vi ứng dụng của AI tạo sinh với cách tiếp cận độc đáo của mình. Theo thông tin từ các công ty công nghệ lớn như AWS, Microsoft Azure và Oracle, RAG cải thiện đáng kể độ chính xác và kịp thời của thông tin, từ đó nâng cao trải nghiệm người dùng. Các nền tảng này sử dụng RAG để tối ưu hóa kết quả của các mô hình ngôn ngữ lớn (LLMs), cung cấp các câu trả lời liên quan hơn.

AWS cho biết RAG nâng cao tính liên quan và độ chính xác của các phản hồi bằng cách tham khảo các cơ sở kiến thức bên ngoài đáng tin cậy. Quá trình này cho phép người dùng nhận được thông tin dựa trên các nghiên cứu và tin tức mới nhất, do đó tăng cường lòng tin và sự hài lòng của họ.

Tại Microsoft Azure, việc tích hợp RAG trong Azure AI Search được nhấn mạnh để cải thiện độ chính xác của việc tìm kiếm thông tin trong các giải pháp doanh nghiệp. Đặc biệt, nó được ghi nhận về khả năng tạo ra các câu trả lời chính xác và cụ thể hơn cho các câu hỏi về nội dung và tài liệu nội bộ. Điều này trực tiếp góp phần vào hiệu quả của các quy trình kinh doanh và cuối cùng dẫn đến sự hài lòng tăng của khách hàng.

Oracle nêu rằng công nghệ RAG nâng cao chất lượng các chatbot và các hệ thống đối thoại khác, cho phép chúng cung cấp các câu trả lời kịp thời và phù hợp với ngữ cảnh cho người dùng. RAG giúp cho việc trích xuất và tìm kiếm dữ liệu nhanh chóng, cải thiện đáng kể khả năng tạo câu trả lời bởi LLMs.

Từ những thông tin này, rõ ràng là việc triển khai RAG đã đạt được kết quả đáng chú ý trong các lĩnh vực như hỗ trợ khách hàng, tìm kiếm doanh nghiệp, và AI đối thoại. Mặc dù không cung cấp các số liệu và dữ liệu cụ thể, nhưng tác động của công nghệ RAG là biến đổi, định nghĩa lại cách sử dụng AI tạo sinh và tối đa hóa tiềm năng của nó.

Triển khai và vận hành công nghệ RAG

RAG trong các dịch vụ điện toán đám mây chính

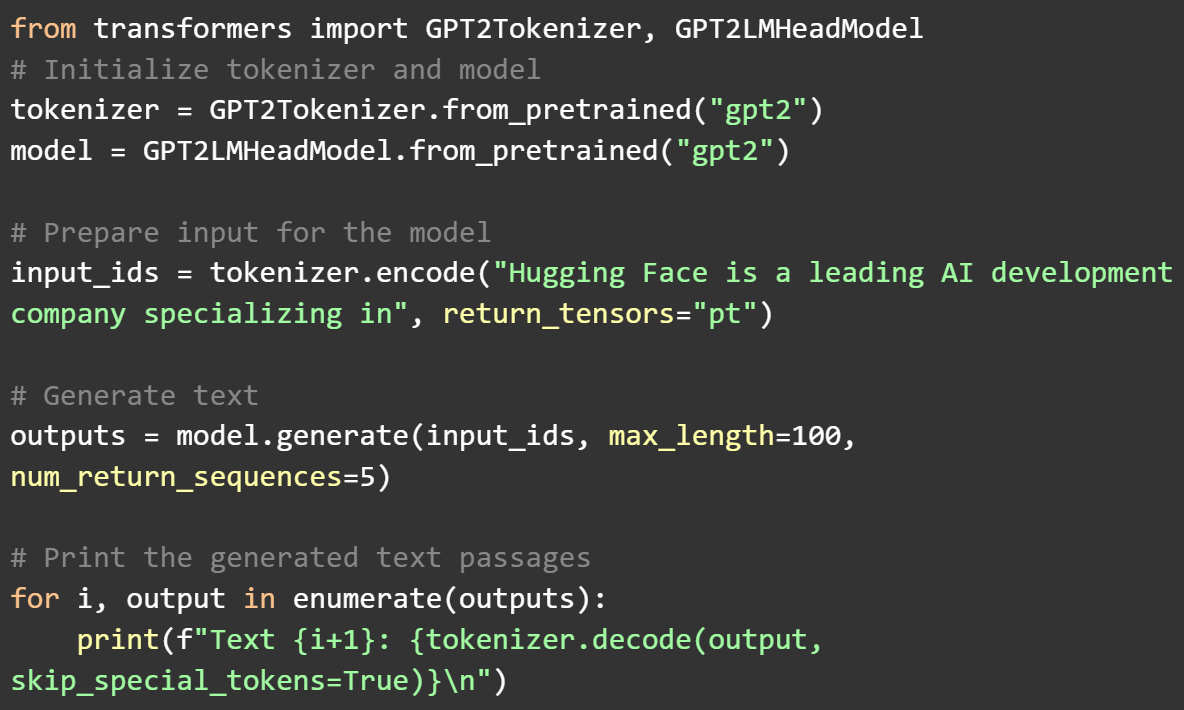

Amazon, Microsoft và Oracle cung cấp các dịch vụ và công cụ đa dạng để làm cho việc sử dụng công nghệ RAG (Retrieval-Augmented Generation) trở nên dễ dàng hơn. Các dịch vụ này nhằm mở rộng khả năng của AI tạo sinh và cho phép các kỹ sư tùy chỉnh nó cho các ứng dụng và nhu cầu kinh doanh cụ thể.

Amazon Web Services (AWS) hỗ trợ triển khai RAG thông qua một dịch vụ tìm kiếm doanh nghiệp gọi là Amazon Kendra. Amazon Kendra sử dụng xử lý ngôn ngữ tự nhiên (NLP) để trích xuất thông tin có ý nghĩa từ văn bản không cấu trúc và tích hợp nó vào quá trình tạo câu trả lời của Mô hình Ngôn ngữ Lớn (LLM). Dịch vụ này cho phép tích hợp trực tiếp với các cơ sở kiến thức và kho tài liệu của doanh nghiệp, cho phép sử dụng kết quả tìm kiếm làm đầu vào cho AI tạo sinh.

Microsoft Azure cung cấp một dịch vụ tìm kiếm gọi là Azure AI Search. Dịch vụ này hỗ trợ tìm kiếm vector và ngữ nghĩa, cho phép các kỹ sư lập chỉ mục nội dung của công ty thành dạng có thể tìm kiếm và sử dụng nó như một phần của mô hình RAG. Azure AI Search cung cấp một công cụ có giá trị để tích hợp nội dung doanh nghiệp vào quá trình tạo câu trả lời của AI tạo sinh, giúp tạo ra các câu trả lời có liên quan hơn.

Oracle hỗ trợ RAG thông qua dịch vụ OCI Generative AI chạy trên Oracle Cloud Infrastructure (OCI). Dịch vụ này cho phép tạo ra các mô hình AI tạo sinh có thể tùy chỉnh và sử dụng các tập dữ liệu và cơ sở kiến thức đặc thù của công ty. Các kỹ sư có thể sử dụng dịch vụ này để phát triển các ứng dụng AI tạo sinh phù hợp với nhu cầu kinh doanh và tích hợp thông tin cụ thể từ tổ chức vào quá trình tạo câu trả lời.

Từ góc độ kỹ thuật, các dịch vụ này cung cấp một nền tảng vững chắc cho các kỹ sư để triển khai linh hoạt cơ chế RAG và tối ưu hóa AI tạo sinh cho các mục đích cụ thể. Bằng cách tận dụng các tính năng độc đáo của từng nền tảng, các kỹ sư có thể khai thác tiềm năng của AI tạo sinh và cung cấp các dịch vụ thông tin chất lượng cao hơn.

Tiêu chuẩn chọn công nghệ RAG

Các tiêu chuẩn để chọn công nghệ RAG (Retrieval-Augmented Generation) là thiết yếu để các kỹ sư xác định giải pháp tốt nhất cho dự án hoặc nhu cầu tổ chức của họ. Quá trình lựa chọn tập trung vào khía cạnh kỹ thuật, hiệu quả chi phí, và dễ dàng tích hợp.

Đầu tiên, về mặt kỹ thuật, điều quan trọng là đánh giá liệu giải pháp RAG có cung cấp sự linh hoạt và khả năng tùy chỉnh để giải quyết các ứng dụng cụ thể hoặc thách thức đặc thù của ngành hay không. Cần xem xét các loại và định dạng dữ liệu mà công ty sở hữu và cách chúng có thể được tích hợp với AI tạo sinh. Ngoài ra, sự đa dạng của các nguồn thông tin được nhắm đến, tần suất cập nhật, và độ chính xác và liên quan của kết quả tìm kiếm là những yếu tố ảnh hưởng trực tiếp đến hiệu suất hệ thống.

Hiệu quả chi phí là một yếu tố quan trọng khác khi triển khai công nghệ RAG. Việc đào tạo và vận hành các mô hình ngôn ngữ lớn (LLMs) thường liên quan đến chi phí đáng kể, do đó chọn một giải pháp cung cấp giá trị tối đa trong ngân sách là thiết yếu. Điều này bao gồm việc xem xét giá cả của truy cập API do nền tảng cung cấp, chi phí của cơ sở hạ tầng cần thiết, và chi phí vận hành lâu dài.

Cuối cùng, dễ dàng tích hợp là tiêu chuẩn quan trọng. Đảm bảo rằng giải pháp RAG được chọn có thể được tích hợp một cách trơn tru vào các hệ thống và quy trình làm việc hiện có là liên kết trực tiếp đến thành công của dự án. Điều này đòi hỏi việc đánh giá tính toàn diện của tài liệu API, cơ cấu hỗ trợ cho các nhà phát triển, và khả năng tương thích với bộ ngăn xếp kỹ thuật hiện tại.

Dựa trên các tiêu chuẩn này, việc lựa chọn công nghệ RAG nên được thực hiện cẩn thận theo các yêu cầu và mục tiêu cụ thể của dự án. Chọn giải pháp tối ưu cho phép khai thác tiềm năng của AI tạo sinh và thực hiện các dịch vụ thông tin chất lượng cao hơn.

Các Bước Triển Khai Công Nghệ RAG

Việc triển khai công nghệ RAG (Retrieval-Augmented Generation) là bước quan trọng để các doanh nghiệp sử dụng AI tạo sinh để cung cấp thông tin chính xác hơn. Quá trình triển khai bao gồm nhiều giai đoạn chính, từ lập kế hoạch đến thực hiện và đánh giá. Dưới đây là các bước chính để triển khai công nghệ RAG một cách hiệu quả.

Bước đầu tiên là làm rõ mục tiêu. Xác định rõ mục đích triển khai RAG, các vấn đề mà nó nhằm giải quyết và giá trị mong đợi mang lại. Tại giai đoạn này, cần xem xét kỹ lưỡng nhu cầu của người dùng mục tiêu và các quy trình cần cải thiện.

Tiếp theo, đánh giá các yêu cầu kỹ thuật. Việc triển khai công nghệ RAG liên quan đến nhiều yêu cầu kỹ thuật, bao gồm việc lựa chọn nguồn dữ liệu phù hợp và khả năng tích hợp với các hệ thống hiện có. Đánh giá khả năng của các dịch vụ đám mây, cơ sở dữ liệu và mô hình AI có sẵn, và chọn bộ công nghệ phù hợp nhất với mục tiêu của dự án.

Sau đó, tạo kế hoạch triển khai. Dựa trên mục tiêu và yêu cầu kỹ thuật, phát triển một kế hoạch chi tiết cho việc triển khai. Kế hoạch này nên bao gồm lịch trình thực hiện, nguồn lực cần thiết, ngân sách và kế hoạch quản lý rủi ro. Vai trò và trách nhiệm của các thành viên trong nhóm cũng được định nghĩa tại giai đoạn này.

Trong giai đoạn thực hiện, bắt đầu xây dựng hệ thống RAG dựa trên kế hoạch. Điều này bao gồm chuẩn bị dữ liệu, đào tạo mô hình AI, tích hợp hệ thống và phát triển giao diện người dùng. Việc đánh giá và kiểm tra định kỳ là rất quan trọng trong quá trình thực hiện để phát hiện và xử lý sớm các vấn đề.

Cuối cùng, đánh giá và tối ưu hóa sau triển khai được thực hiện. Sau khi hệ thống được triển khai trong môi trường vận hành, hiệu suất của nó được đánh giá và thu thập phản hồi từ người dùng. Dựa trên thông tin này, việc cải thiện và tối ưu hóa hệ thống được tiến hành liên tục.

Thông qua các bước này, các công ty có thể triển khai thành công công nghệ RAG và khai thác tiềm năng của AI tạo sinh. Quá trình triển khai phức tạp và đa dạng, đòi hỏi một cách tiếp cận có kế hoạch và từng giai đoạn.