Xin chào, tôi là Kakeya, đại diện của Scuti.

Công ty chúng tôi chuyên về phát triển offshore và phát triển dựa trên phòng thí nghiệm tại Việt Nam với trọng tâm là AI tạo sinh, cũng như cung cấp các dịch vụ tư vấn AI tạo sinh. Gần đây, chúng tôi may mắn nhận được nhiều yêu cầu phát triển hệ thống kết hợp với AI tạo sinh.

Meta đã gây chú ý gần đây khi công bố LLM mới nhất của mình, “Llama 3”, dưới dạng mã nguồn mở. Tôi đã thử nghiệm Llama 3 thông qua một dịch vụ gọi là Groq, cho phép vận hành siêu tốc suy luận LLM. Tôi rất vui được chia sẻ quá trình bao gồm cả các hoạt động thực tế. Llama 3 rất ấn tượng, nhưng điều làm tôi thực sự kinh ngạc là khả năng phản hồi quá nhanh của Groq…!

Mục lục

- Giới thiệu Groq

- Giới thiệu Llama 3

- Thử nghiệm Llama 3 với Groq

- Thử nghiệm phiên bản trình duyệt của Chatbot UI

- Thử nghiệm phiên bản cục bộ của Chatbot UI

Giới thiệu Groq

Groq là gì?

Groq là công ty phát triển phần cứng tùy chỉnh và Đơn vị Xử lý Ngôn ngữ (LPU) được thiết kế đặc biệt để tăng tốc suy luận của các mô hình ngôn ngữ lớn (LLM). Công nghệ này được đặc trưng bởi tốc độ xử lý nhanh hơn đáng kể so với phần cứng thông thường.

LPU của Groq đạt hiệu suất suy luận nhanh hơn đến 18 lần so với các nhà cung cấp dịch vụ dựa trên đám mây khác. Groq hướng đến việc tối đa hóa hiệu suất của các ứng dụng AI thời gian thực bằng cách sử dụng công nghệ này.

Ngoài ra, gần đây Groq đã thành lập một bộ phận mới có tên là “Groq Systems,” hỗ trợ triển khai chip vào các trung tâm dữ liệu và xây dựng các trung tâm dữ liệu mới. Hơn nữa, Groq đã mua lại Definitive Intelligence, một nhà cung cấp giải pháp AI cho doanh nghiệp, để tăng cường thêm sức mạnh công nghệ và ảnh hưởng thị trường của mình.

LPU của Groq là gì?

LPU (Đơn vị Xử lý Ngôn ngữ) là một bộ xử lý chuyên dụng được thiết kế để cải thiện hiệu suất và độ chính xác suy luận của các mô hình ngôn ngữ AI. Khác với GPU truyền thống, LPU được chuyên môn hóa cho các nhiệm vụ tính toán tuần tự, loại bỏ các điểm nghẽn về tính toán và băng thông bộ nhớ cần thiết cho các mô hình ngôn ngữ lớn. Ví dụ, LPU giảm thời gian tính toán cho mỗi từ so với GPU và không gặp phải điểm nghẽn băng thông bộ nhớ bên ngoài, do đó cung cấp hiệu suất đáng kể tốt hơn so với bộ xử lý đồ họa.

Về mặt kỹ thuật, LPU chứa hàng ngàn yếu tố xử lý đơn giản (PE), được sắp xếp theo mảng Single Instruction, Multiple Data (SIMD). Điều này cho phép cùng một lệnh được thực hiện đồng thời cho mỗi điểm dữ liệu. Ngoài ra, một đơn vị điều khiển trung tâm (CU) phát lệnh và quản lý dòng chảy dữ liệu giữa phân cấp bộ nhớ và PE, duy trì giao tiếp đồng bộ nhất quán.

Hiệu quả chính của việc sử dụng LPU là tăng tốc các nhiệm vụ AI và học máy. Ví dụ, Groq đã chạy mô hình Llama-2 70B với tốc độ 300 token mỗi giây cho mỗi người dùng trên hệ thống LPU, đây là một cải tiến đáng kể so với 100 token và 240 token trước đây. Như vậy, LPU có thể xử lý các nhiệm vụ suy luận AI theo thời gian thực với độ trễ thấp và cung cấp chúng trong gói hiệu quả năng lượng. Điều này cho phép các thay đổi đột phá trong các lĩnh vực như tính toán hiệu năng cao (HPC) và tính toán cạnh.

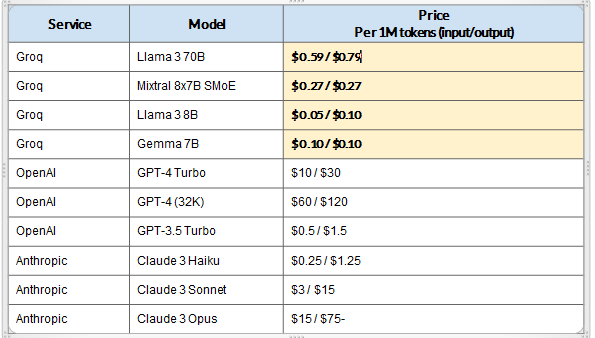

API Giá rẻ bất ngờ của Groq

Tài nguyên phần cứng của Groq có thể được truy cập thông qua API do Groq cung cấp. Một trong những đặc điểm nổi bật của dịch vụ Groq là chi phí sử dụng API này cực kỳ thấp

Nói cách khác, Groq vừa nhanh vừa rẻ

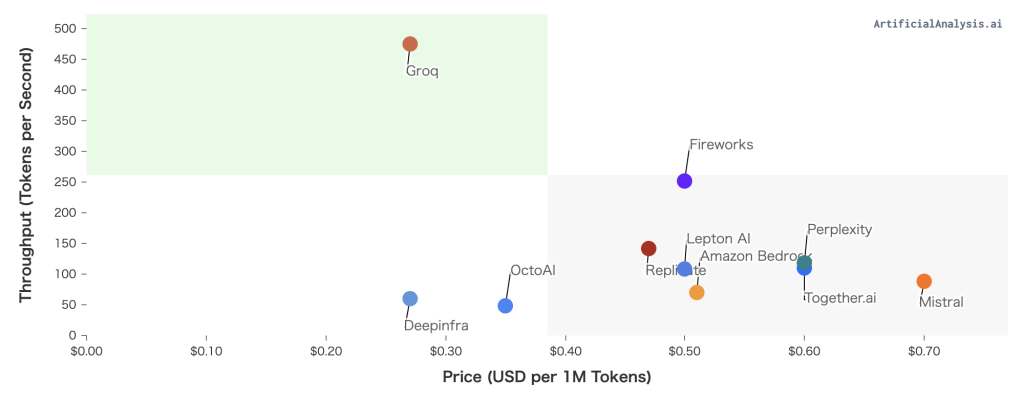

Biểu đồ dưới đây, do ArtificialAnalysis.ai cung cấp, so sánh các nhà cung cấp API, với giá cả trên trục ngang và thông lượng (token mỗi giây) trên trục dọc. Từ biểu đồ này, có thể thấy rõ ràng rằng Groq nhanh và rẻ đáng kể, đặc biệt nổi bật về thông lượng so với các nhà cung cấp API khác.

Giới thiệu Llama 3

Tổng quan và các đặc điểm của Llama 3

Llama 3 là mô hình ngôn ngữ lớn (LLM) mới nhất do Meta phát triển. AI này được đào tạo trên một tập dữ liệu văn bản khổng lồ, cho phép nó hiểu và phản hồi ngôn ngữ một cách toàn diện. Llama 3 phù hợp với nhiều nhiệm vụ khác nhau bao gồm tạo nội dung sáng tạo, dịch thuật ngôn ngữ và cung cấp thông tin cho các truy vấn. Mô hình này có sẵn trên các nền tảng như AWS, Databricks và Google Cloud, phục vụ làm cơ sở để các nhà phát triển và nhà nghiên cứu tiếp tục thúc đẩy AI. Bằng cách cung cấp Llama 3 dưới dạng mã nguồn mở, Meta nâng cao tính minh bạch của công nghệ và thúc đẩy sự hợp tác với nhiều nhà phát triển.

Dưới đây là một số đặc điểm của Llama 3 do Meta công bố:

- Mô hình tham số cao cấp: Llama 3 được phát triển như một mô hình có số lượng tham số khổng lồ, có hai phiên bản: 8B (tám tỷ) và 70B (bảy mươi tỷ), cho phép nó thể hiện hiệu suất cao trong việc hiểu và tạo ngôn ngữ.

- Đánh giá theo tiêu chuẩn ngành: Llama 3 được đánh giá bằng nhiều tiêu chuẩn ngành như ARC, DROP và MMLU, đạt kết quả hàng đầu trong các bài kiểm tra này. Cụ thể, nó cho thấy sự cải thiện đáng kể về độ chính xác nhận dạng và suy luận so với các mô hình trước.

- Hỗ trợ đa ngôn ngữ: Llama 3 được đào tạo với tập dữ liệu hơn 15 nghìn tỷ token bao gồm dữ liệu chất lượng cao để hỗ trợ hơn 30 ngôn ngữ, không chỉ tiếng Anh mà còn nhiều ngôn ngữ khác, phục vụ người dùng toàn cầu.

- Cải tiến Tokenizer: Tokenizer mới được phát triển có 128,000 từ vựng, cho phép mã hóa ngôn ngữ hiệu quả hơn. Điều này nâng cao tốc độ và độ chính xác của mô hình, cho phép nó xử lý các văn bản phức tạp một cách thích hợp.

- Cải thiện hiệu quả suy luận: Việc áp dụng công nghệ Grouped Query Attention (GQA) đã nâng cao hiệu quả suy luận của mô hình, cho phép xử lý nhanh các tập dữ liệu lớn và tạo điều kiện cho phản hồi theo thời gian thực.

- Tăng cường độ bảo mật và đáng tin cậy: Các công cụ bảo mật mới như Llama Guard 2, Code Shield và CyberSec Eval 2 đã được giới thiệu để nâng cao an toàn của nội dung do mô hình tạo ra, giảm thiểu rủi ro sản xuất nội dung không phù hợp.

- Khả năng truy cập mã nguồn mở: Llama 3 được cung cấp hoàn toàn dưới dạng mã nguồn mở, cho phép các nhà nghiên cứu và nhà phát triển trên toàn thế giới truy cập tự do, cải thiện và sử dụng nó để phát triển ứng dụng. Mã nguồn mở giúp thúc đẩy sự đổi mới thêm.

Đánh giá hiệu suất của Llama 3 theo các tiêu chuẩn ngành

Llama 3 đã thể hiện hiệu suất nổi bật trong các tiêu chuẩn ngành, đặc biệt là xuất sắc trong các lĩnh vực hiểu ngôn ngữ, suy luận logic, và khả năng giải quyết vấn đề. Các mô hình mới được giới thiệu với 8 tỷ (8B) và 70 tỷ (70B) tham số cho thấy sự cải thiện đáng kể về độ chính xác trong hiểu và phản hồi so với mô hình trước đó, Llama 2.

Llama 3 được đánh giá cao về khả năng tạo mã và thực hiện các nhiệm vụ dựa trên chỉ thị, và những khả năng này được củng cố thêm bởi phương pháp đào tạo độc quyền của Meta. Ngoài ra, mô hình này hỗ trợ đa ngôn ngữ, cung cấp hiệu suất chất lượng cao trong hơn 30 ngôn ngữ.

Hiện tại, Meta đã công bố hai phiên bản của mô hình Llama 3: Llama 3 8B và Llama 3 70B, trong đó “8B” có 8 tỷ tham số và “70B” có 70 tỷ tham số. Hình dưới đây cho thấy kết quả của các đánh giá tiêu chuẩn ngành do Meta công bố, với mô hình 70B thể hiện hiệu suất cao hơn Gemini Pro và Claude3.

Nguồn: https://llama.meta.com/llama3/

So sánh giữa Llama 3 và Llama 2

Llama 3 đã có những cải tiến đáng kể so với Llama 2 ở nhiều khía cạnh. Cụ thể, bộ dữ liệu được sử dụng để đào tạo mô hình đã tăng gấp bảy lần, và dữ liệu liên quan đến mã đã tăng gấp bốn lần.

Kết quả là, mô hình đã trở nên hiệu quả hơn trong việc xử lý các nhiệm vụ ngôn ngữ phức tạp. Đặc biệt, Llama 3 vượt trội hơn mô hình trước đáng kể trong khả năng tạo mã và thực hiện các nhiệm vụ dựa trên chỉ thị.

Việc áp dụng tokenizer mới cũng đã cải thiện hiệu quả mã hóa ngôn ngữ, góp phần nâng cao hiệu suất tổng thể. Ngoài ra, một thiết kế tính đến yếu tố an toàn đã được triển khai, giới thiệu một hệ thống lọc mới để giảm thiểu rủi ro tạo ra các phản hồi không phù hợp.

| Đặc điểm | Llama 3 | Llama 2 |

| Số lượng tham số | Các phiên bản với 8 tỷ và 70 tỷ tham số | Ít tham số hơn (số liệu chính xác không được công bố) |

| Hiệu suất trong Benchmark | Hiệu suất cải thiện trong các benchmark ARC, DROP, MMLU | Có thể có điểm thấp hơn trong cùng các benchmark |

| Khả năng | Khả năng suy luận mạnh mẽ, tạo văn bản sáng tạo | Có thể cung cấp các khả năng tương tự nhưng ở mức độ thấp hơn |

| Khả năng tiếp cận | Công khai cho mục đích nghiên cứu | Chi tiết về khả năng tiếp cận không rõ ràng, có lẽ ít được công khai hơn |

Thử nghiệm Llama 3 với Groq

Hiện tại, “Meta AI” chưa được công bố tại Nhật Bản.

Người ta có thể trải nghiệm tạo hình ảnh nhanh và trò chuyện sử dụng Llama 3 thông qua trợ lý AI “Meta AI” do Meta phát hành. Tuy nhiên, tính đến ngày 1 tháng 5 năm 2024, Meta AI chỉ được công bố ở các khu vực nói tiếng Anh và chưa được phát hành tại Nhật Bản.

Thử Nghiệm Llama 3 với Groq

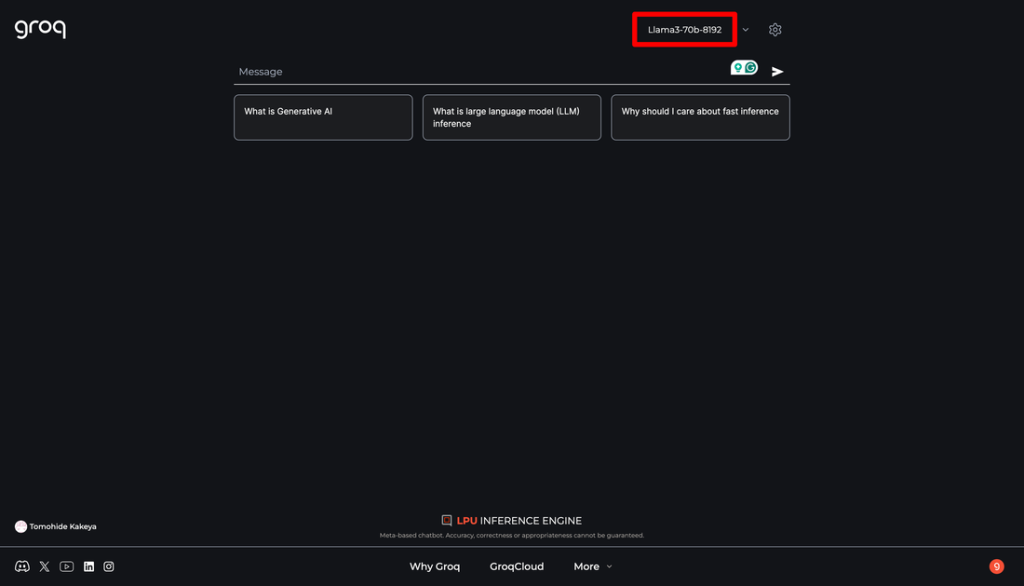

Tuy nhiên, như đề cập ở trên, vì Groq đã hỗ trợ Llama 3 nên bạn có thể trải nghiệm Llama 3 bằng cách đăng nhập vào Groq. Hơn nữa, sử dụng cực kỳ nhanh và miễn phí!

Cách sử dụng rất đơn giản: chỉ cần đăng nhập vào Groq, và chọn mô hình từ menu thả xuống ở góc trên bên phải. Để thử nghiệm (?), hãy chọn mô hình 70B.

Dưới đây là một hướng dẫn tôi đã thử. Ngay cả khi được chỉ định, đầu ra là bằng tiếng Anh, vì vậy từ biểu tượng bánh răng ở góc trên bên phải, bạn có thể thiết lập Hệ thống Nhắc để xuất ra tiếng Nhật trước.

Băng thông khoảng 300 token mỗi giây. Bạn sẽ thấy rằng tốc độ phản hồi cực nhanh. Tuy nhiên, đây là lệnh để tạo ra truyện ngắn, và tôi cảm thấy độ chính xác không tốt vì các câu văn giống nhau được lặp lại.

Ngoài ra, giao diện Groq không thực sự thực tiễn để sử dụng bởi vì việc nhấn phím Enter khi xác nhận chuyển đổi văn bản tiếng Nhật hoàn thành nhập liệu trò chuyện.

Thử phiên bản trình duyệt của Chatbot UI

Trong khi tìm kiếm một phương pháp tốt, tôi đã tìm thấy Chatbot UI, tương thích với API của Groq, cho phép sử dụng Llama 3 qua Groq.

Chatbot UI có giao diện giống như ChatGPT cho phép chuyển đổi giữa các LLM khác nhau.

Chatbot UI là mã nguồn mở và có thể chạy trên PC cá nhân, nhưng cũng có phiên bản trình duyệt. Vì thiết lập môi trường địa phương khá phức tạp, tôi quyết định sử dụng phiên bản trình duyệt trong thời gian này.

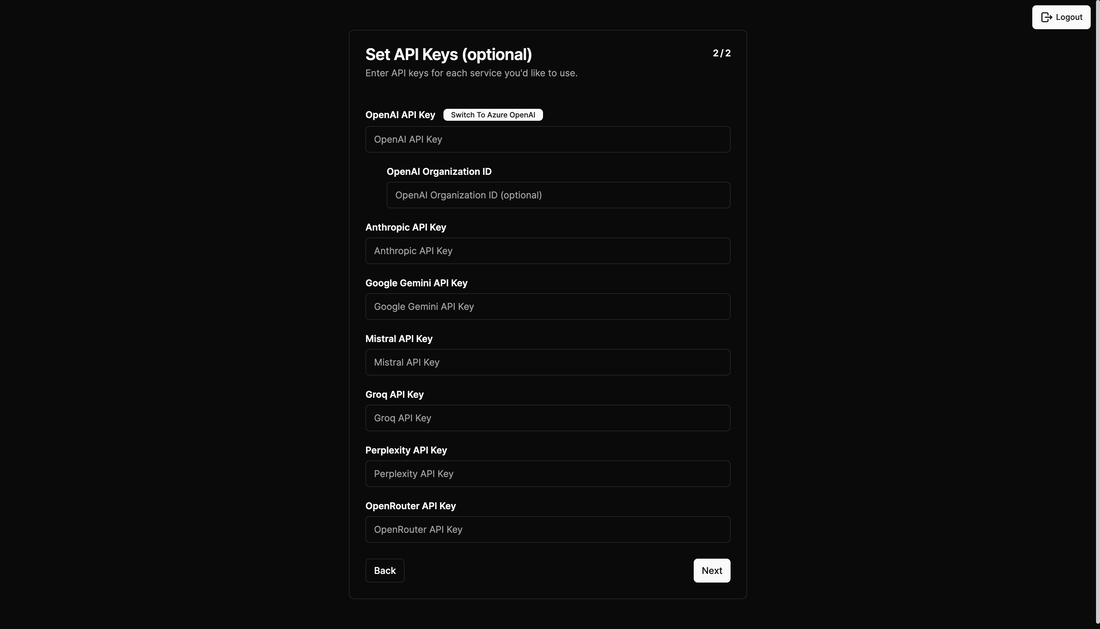

Để sử dụng nhiều LLM trong Chatbot UI, bạn cần kết nối với API của từng LLM, điều này đòi hỏi phải lấy các API key trước. Lần này, tôi muốn so sánh ChatGPT, Claude và Groq (Llama 3), vì vậy tôi sẽ lấy API key từ OpenAI, Anthropic và Groq. Ngoài API Key, bạn cũng cần ID Mô hình và URL Cơ sở (tùy chọn) cho kết nối API.

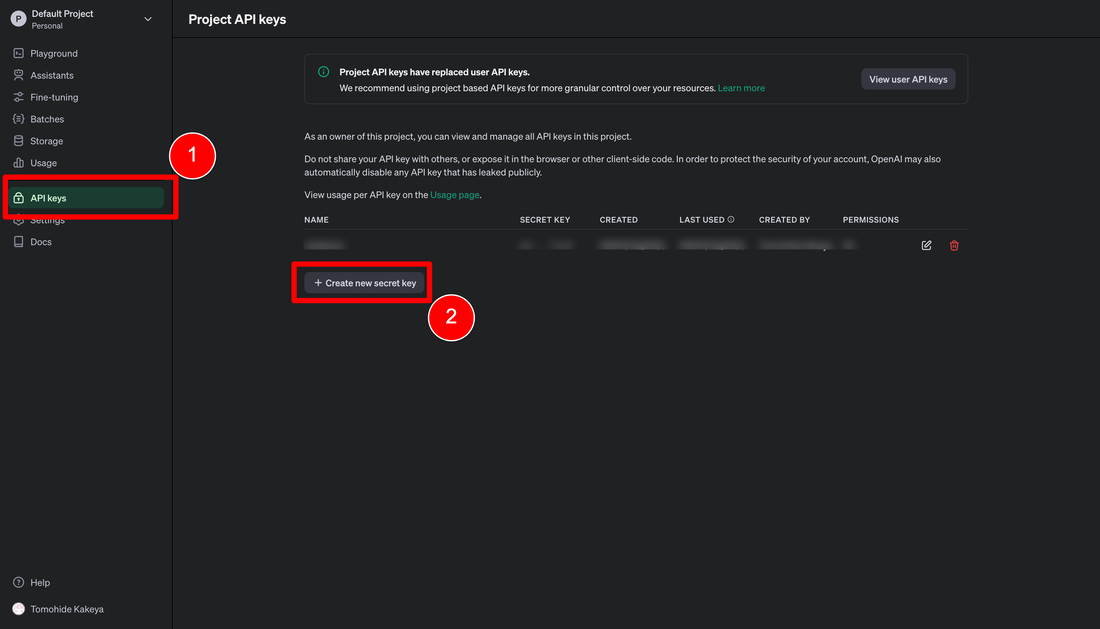

Lấy API key của OpenAI

Bạn có thể phát hành từ menu “API keys” trong màn hình quản lý của OpenAI.

Có một nút gọi là “Create new secret key”; khi nhấp vào đó sẽ mở một popup. Sau khi nhập thông tin cần thiết, API Key sẽ được phát hành. Hãy chắc chắn lưu key này một cách an toàn, vì về sau bạn không thể kiểm tra nó nữa.

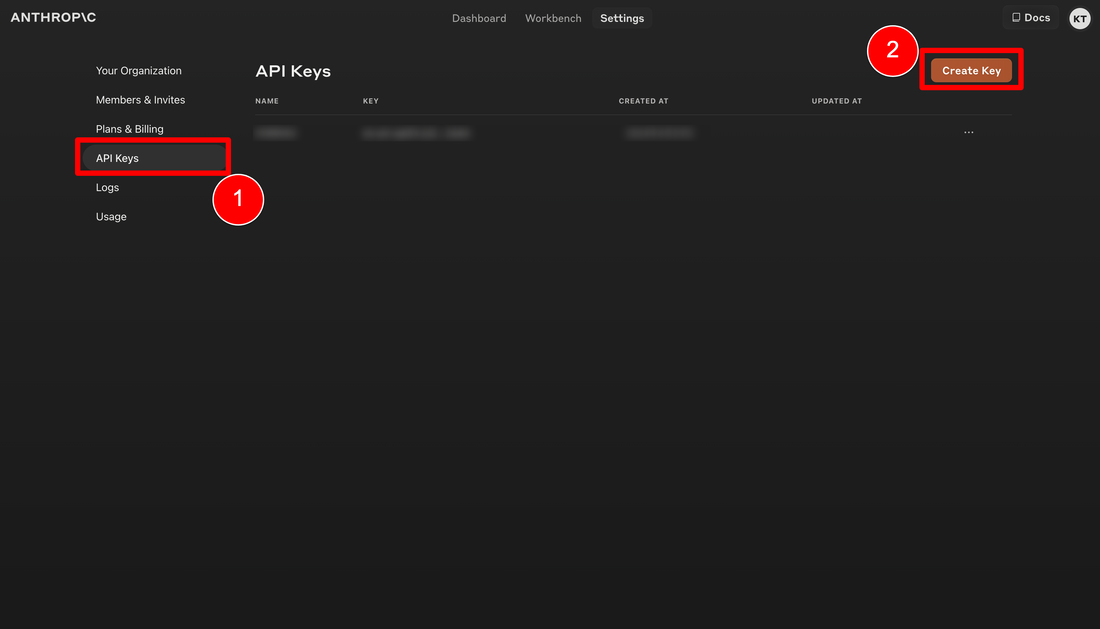

Lấy API key của Anthropic

Bạn có thể lấy nó theo cách gần giống như OpenAI. Nó có thể được phát hành từ menu “API Keys” trong màn hình quản lý của Anthropic. Nhấp vào nút “Create Key”, một popup sẽ mở ra, và nhập tên cho key sẽ phát hành nó.

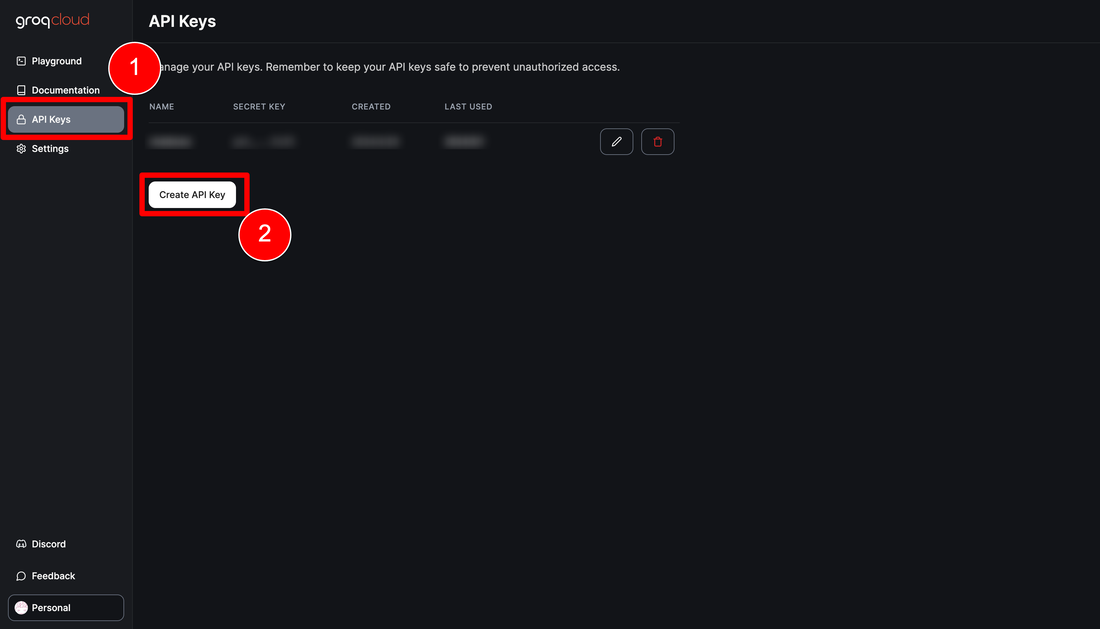

Lấy API key của Groq

Phương pháp lấy API Key của Groq tương tự như trên.

Có một liên kết gọi là “GroqCloud” ở phía dưới màn hình Groq mà bạn đã đăng nhập trước đó. Nhấp vào liên kết này mở màn hình quản lý, từ đó bạn có thể phát hành key từ “Create API Key” trong menu “API Keys”.

Đăng Nhập vào Phiên Bản Trình Duyệt của Chatbot UI

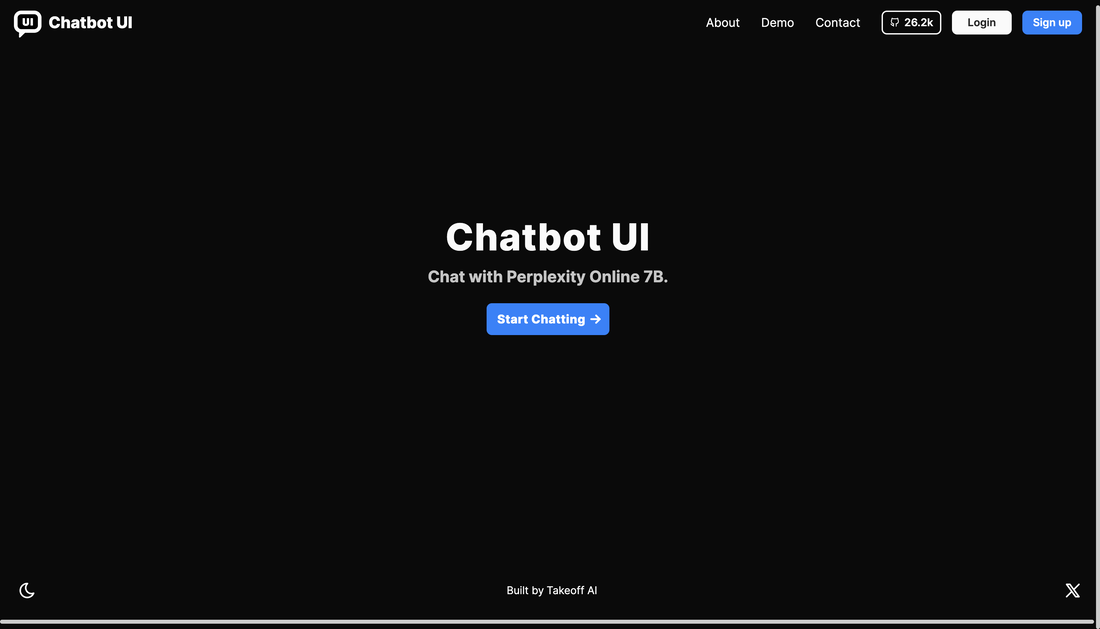

Bây giờ mọi thứ đã sẵn sàng, hãy đăng nhập vào phiên bản trình duyệt của Chatbot UI.

Khi bạn truy cập phiên bản trình duyệt của Chatbot UI, màn hình ban đầu hiển thị sẽ có nút “Start Chatting” (Bắt đầu trò chuyện). Nhấp vào nút này để tiếp tục.

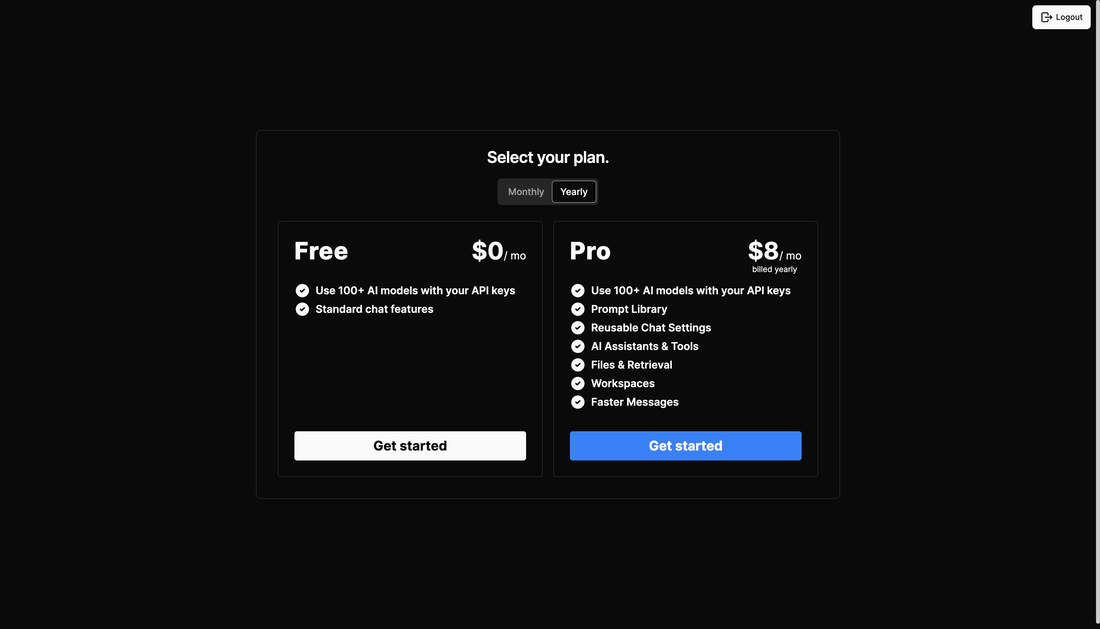

Tôi muốn sử dụng chức năng tìm kiếm tệp để so sánh hiệu suất, vì vậy tôi đã chọn kế hoạch trả phí. Giá là $8 mỗi tháng với hợp đồng hàng năm, hoặc $10 mỗi tháng với việc gia hạn hàng tháng.

Khi cài đặt thanh toán hoàn tất, bạn sẽ được chuyển đến màn hình để đăng ký API Key như đã hiển thị.

Nhập các API Key bạn đã nhận được trước đó từ OpenAI, Anthropic và Groq. Việc đăng ký ban đầu này hoàn tất và màn hình trò chuyện sẽ mở ra.

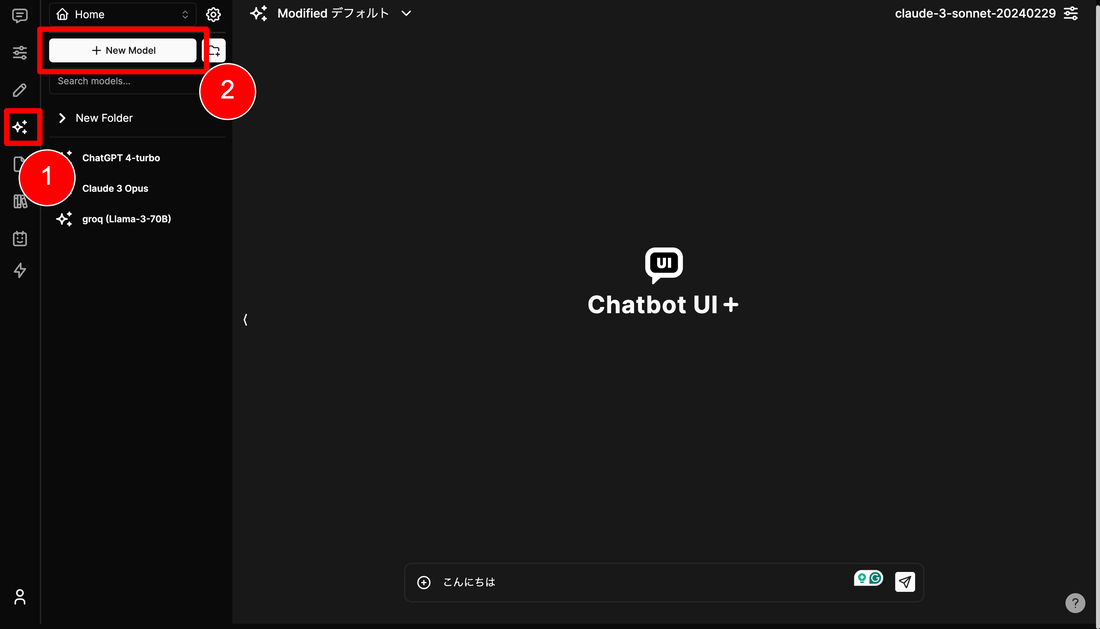

Tiếp theo, bạn cần đăng ký mô hình bạn muốn sử dụng (việc đăng ký API Key trước đó chưa đủ để sử dụng chúng). Dấu hiệu lấp lánh ở bên trái (?) là menu mô hình; nhấp vào nút “New Model” (Mô hình mới) để đăng ký mô hình bạn muốn sử dụng.

Lần này, tôi đã nhập như sau:

- ChatGPT 4-turbo

- Name: ChatGPT 4-turbo (bất cứ cái gì bạn có thể nhận biết)

- Model ID: gpt-4-turbo

- Base URL: không có

- API Key: Key bạn đã nhận được trước đó

- Claude 3 Opus

- Name: Claude 3 Opus (bất cứ cái gì bạn có thể nhận biết)

- Model ID: claude-3-opus-20240229

- Base URL: https://api.anthropic.com/v1

- API Key: Key bạn đã nhận được trước đó

- Groq (Llama-3-70B)

- Name: Groq (Llama-3-70B) (bất cứ cái gì bạn có thể nhận biết)

- Model ID: llama3-70b-8192

- Base URL: https://api.groq.com/openai/v1

- API Key: Key bạn đã nhận được trước đó

Bạn có thể tham khảo Model ID từ các nguồn sau:

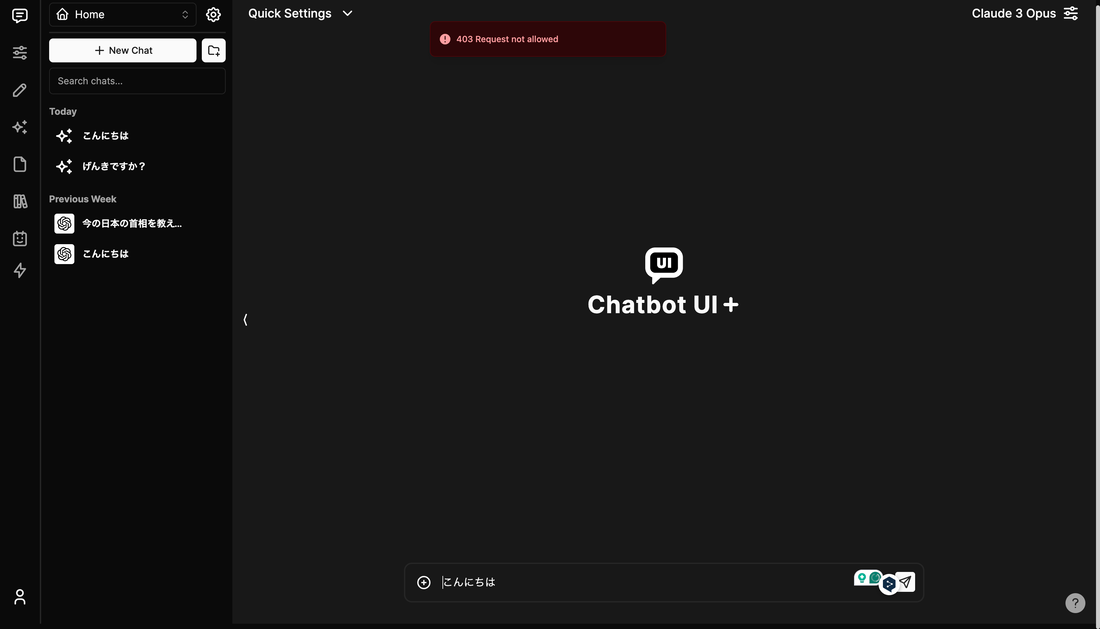

Sau khi thiết lập, GPT4 và Groq đã hoạt động, nhưng đã xảy ra lỗi với Claude như đã mô tả ở trên. Mặc dù đã thử thay đổi Base URL và Model ID nhưng không giải quyết được, vì vậy tôi đã từ bỏ và quyết định xây dựng phiên bản cục bộ… Nếu bạn đã quản lý để làm cho Claude 3 Opus hoạt động trên trình duyệt, tôi sẽ rất vui nếu được nghe thêm từ bạn.

Thử nghiệm phiên bản cục bộ của Chatbot UI

Thiết lập môi trường cục bộ cho Chatbot UI

Phiên bản cục bộ có thể được thiết lập dễ dàng bằng các bước sau- bằng cách làm theo hướng dẫn trong kho lưu trữ GitHub của nhà phát triển Mckay Wrigley. Thực hiện các lệnh sau trong terminal của Mac để thiết lập.

1. Clone kho lưu trữ

Trước tiên, clone kho lưu trữ Chatbot UI từ GitHub.

$ git clone https://github.com/mckaywrigley/chatbot-ui.git

2. Cài đặt các biến phụ thuộc

Di chuyển đến thư mục đã clone và cài đặt các biến phụ thuộc cần thiết.

$ cd chatbot-ui

$ npm install

3. Cài đặt Docker

Docker là cần thiết để chạy Supabase tại cục bộ. Cài đặt Docker từ trang web chính thức.

4. Cài đặt Supabase CLI

Để cài đặt Supabase CLI, thực hiện lệnh sau.

$ brew install supabase/tap/supabase

5. Khởi động Supabase

Khởi động Supabase bằng cách thực hiện lệnh sau.

$ supabase start

6. Thiết lập các biến môi trường

Sao chép tệp .env.local.example thành .env.local và thiết lập các giá trị cần thiết.

$ cp .env.local.example .env.local

7. Kiểm tra thông tin liên quan đến Supabase

Nhập các giá trị cần thiết như API URL vào tệp .env.local.

$ supabase status

[Results of supabase status]

$ vi ./.env.local

- NEXT_PUBLIC_SUPABASE_URL: Chỉ định “API URL” từ status

- NEXT_PUBLIC_SUPABASE_ANON_KEY: Chỉ định “anon key” từ status

- SUPABASE_SERVICE_ROLE_KEY: Chỉ định “service_role key” từ status

8. Thiết lập cơ sở dữ liệu

Chỉnh sửa tệp SQL để thiết lập ban đầu trong Supabase. Tham khảo kết quả supabase status cho các giá trị cụ thể. Trong trường hợp của tôi, nó hoạt động mà không cần thay đổi gì. Hãy chắc chắn rằng “service_role_key” ở dòng 54 khớp với service_role_key từ kết quả thực hiện supabase status.

9. Chạy ứng dụng cục bộ

Thực hiện lệnh sau để khởi động ứng dụng cục bộ

$ npm run chat

Bây giờ, bạn có thể truy cập ứng dụng Chatbot UI trong trình duyệt tại http://localhost:3000.

Thử nghiệm Llama 3 Qua Groq trên Chatbot UI

Khi bạn truy cập http://localhost:3000, màn hình thiết lập ban đầu giống như phiên bản trình duyệt sẽ được hiển thị. Đăng ký theo cách và nội dung giống như trước.

Tuy nhiên, Claude 3 Opus hiển thị lỗi “404 Not Found” và không thể sử dụng. Claude 3 Sonnet và Claude 3 Haiku, có thể chỉ định mặc định, hoạt động bình thường, vì vậy có vẻ như Chatbot UI có thể chưa hỗ trợ Opus.

Hãy chỉ định “Groq (Llama 3)” làm mô hình, và nhập một số lời nhắc để xem đầu ra của Llama 3.

Trước tiên, tôi đã hỏi một câu hỏi liên quan đến AI hiệu suất cao “GPT2” mới xuất hiện gần đây, câu hỏi không có câu trả lời dứt khoát.

Phản hồi rất mơ hồ.

Tiếp theo, hãy kiểm tra tốc độ của đầu ra.

Tốc độ thực sự rất nhanh! Ngay cả bao gồm thời gian truyền thông API, không có bất kỳ sự chờ đợi căng thẳng nào!

Llama 3 vs GPT-4 Turbo vs Claude 3 Sonnet – Trận Đấu 3 Vòng!

Hãy nhập cùng ba lệnh vào Llama 3, GPT-4 Turbo và Claude 3 Sonnet và so sánh kết quả đầu ra.

Tạo Văn Bản Để Giải Thích Một Từ Khóa

Lệnh là:

“Retrieval-Augmented Generation (RAG) là gì? Hãy tóm tắt nó trong khoảng 500 ký tự để một sinh viên năm tư ngành công nghệ thông tin có thể hiểu.”

So sánh kết quả phản hồi đầu tra (từ trái: Llama 3, GPT-4 Turbo, Claude 3 Sonnet. Xác nhận lệnh từ phải trong chế độ nhanh gấp đôi)

So sánh kết quả phản hồi đầu ra (từ trái: Llama 3, GPT-4 Turbo, Claude 3 Sonnet)

Không có sự khác biệt đáng kể về độ chính xác của văn bản được tạo bởi bất kỳ mô hình nào trong số chúng. Tuy nhiên, tốc độ phản hồi đầu ra thì Groq vẫn nhanh hơn một cách áp đảo.

Giải Một Câu Đố Logic

Đây là một câu đố logic điển hình. Lệnh là:

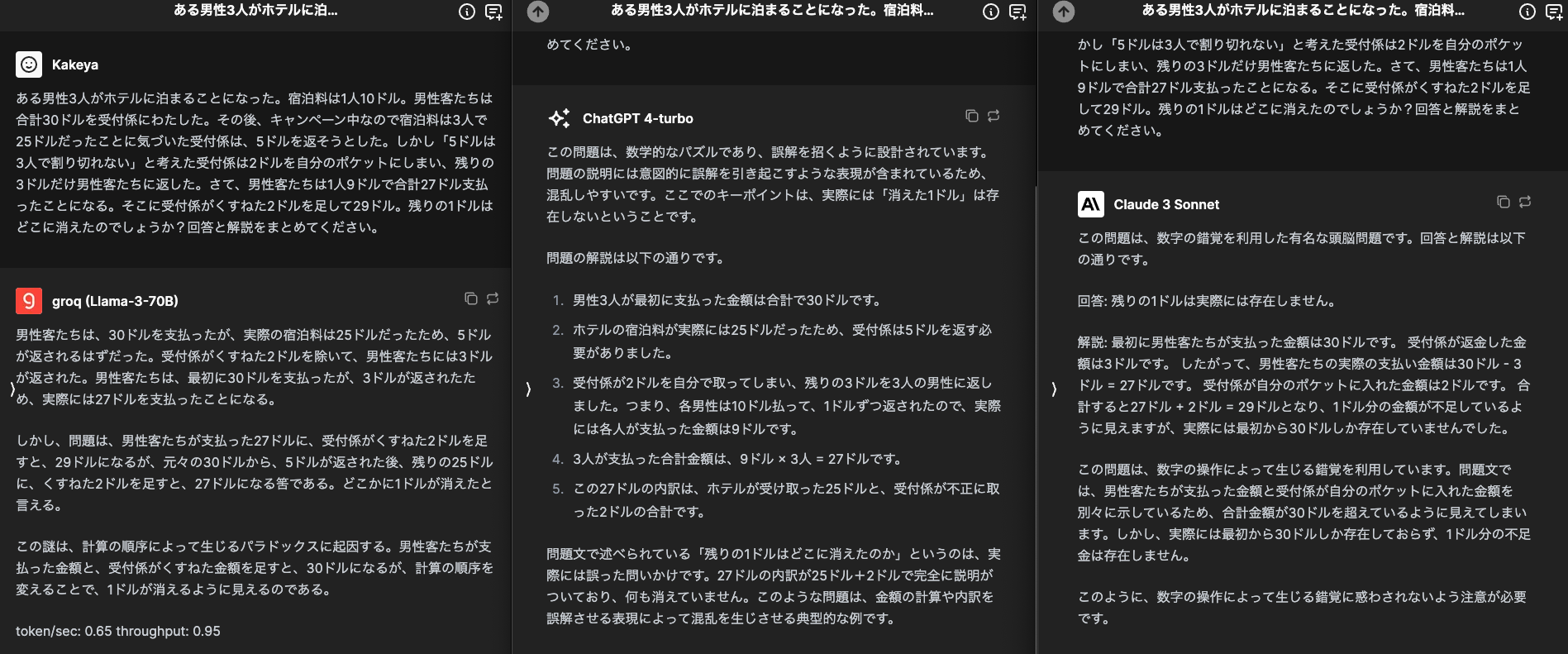

“Ba người đàn ông ở lại khách sạn. Giá phòng là $10 mỗi người. Các khách hàng đã trả tổng cộng $30 cho lễ tân. Sau đó, lễ tân nhận ra rằng có một chiến dịch và giá phòng là $25 cho ba người, vì vậy họ quyết định trả lại $5. Tuy nhiên, lễ tân nghĩ rằng $5 không thể chia đều cho ba người, nên họ bỏ $2 vào túi và trả lại $3 cho khách hàng. Các khách hàng đã trả $9 mỗi người, tổng cộng $27. Thêm $2 mà lễ tân đã bỏ túi là $29. Vậy $1 còn lại đã đi đâu? Hãy cung cấp câu trả lời và giải thích.”

So sánh kết quả phản hồi đầu ra (từ trái: Llama 3, GPT-4 Turbo, Claude 3 Sonnet. Xác nhận lệnh từ phải trong chế độ nhanh gấp đôi.)

So Sánh Kết Quả Đầu Ra (từ trái: Llama 3, GPT-4 Turbo, Claude 3 Sonnet)

Kết quả là chiến thắng hoàn toàn dành cho GPT-4 Turbo.

GPT-4 Turbo đã cung cấp một lời giải thích rõ ràng và logic về câu trả lời.

Claude 3 Sonnet cũng đã cung cấp một lời giải thích, nhưng không rõ ràng về lý do.

Llama 3 không giải thích được lý do quan trọng, vì vậy được đánh giá là không thành công.

Tóm tắt một bài báo đã được đăng tải

Tôi đã tải lên một bài báo về một mô hình gọi là RAPTOR cải thiện độ chính xác tìm kiếm tài liệu trong RAG và yêu cầu tóm tắt nội dung. Lệnh là:

“Hãy tóm tắt nội dung của tệp PDF đã tải lên theo cách mà một sinh viên năm tư ngành công nghệ thông tin có thể hiểu, sử dụng các biểu hiện cụ thể và định lượng nhất có thể, trong khoảng 1000 ký tự tiếng Nhật. Vui lòng tóm tắt ngắn gọn nội dung kỹ thuật, tập trung vào các điểm quan trọng và nêu rõ cái gì là đổi mới và cái gì là vượt trội so với công nghệ truyền thống.”

Do thời gian tải tệp khá lâu và kết quả đầu ra dài, tôi sẽ dán trực tiếp văn bản được tạo ra dưới đây thay vì ảnh chụp màn hình.

ーーー

<Llama 3>

The provided text appears to be a collection of research papers and articles related to natural language processing, specifically focusing on language models, question answering, and text summarization. Here is a summary of the main points:

Language Models: The text discusses the development of language models, such as GPT-4, that can generate coherent and context-specific text. These models are trained on large datasets and can be fine-tuned for specific tasks.

Question Answering: The text explores various question answering models, including UnifiedQA, that can retrieve relevant information from a large corpus of text. These models are evaluated on datasets such as QuALITY, QASPER, and NarrativeQA.

Text Summarization: The text touches on the topic of text summarization, highlighting the importance of summarizing long documents and the challenges associated with it. Models such as Longformer and Hybrid Hierarchical Retrieval are mentioned as approaches to tackle this task.

Retrieval-Augmented Generation: The text discusses the concept of retrieval-augmented generation, which involves using a retrieval mechanism to augment language models with relevant information from a knowledge base.

Evaluation Metrics: The text mentions various evaluation metrics used to assess the performance of language models and question answering systems, including BLEU score, ROUGE score, and METEOR score.

Applications: The text hints at the potential applications of these technologies in areas such as information retrieval, text classification, and chatbots.

In summary, the text provides an overview of the current state of natural language processing research, highlighting advancements in language models, question answering, and text summarization.

ーーー

<GPT-4 Turbo>

Tóm tắt nội dung của tệp PDF, nó mô tả nghiên cứu về một hệ thống tìm kiếm thông tin mới gọi là “RAPTOR.” Hệ thống này có thể cung cấp thông tin liên quan và toàn diện hơn so với các hệ thống tìm kiếm truyền thống. Đặc biệt, RAPTOR có thể thu được các giải thích chi tiết về không chỉ các mô tả ngắn mà còn các phần chính của câu chuyện, cải thiện hiệu suất trong các nhiệm vụ hạ lưu.

Cụ thể, so sánh RAPTOR với DPR (Dense Passage Retrieval) truyền thống, RAPTOR được cho là có thể tạo ra các câu trả lời xem xét ngữ cảnh rộng hơn. Ví dụ, trong câu chuyện về Lọ Lem, DPR tạo ra các câu trả lời chỉ xem xét phần đầu của câu chuyện, trong khi RAPTOR nắm bắt chủ đề của câu chuyện từ góc nhìn toàn diện hơn, cung cấp một câu trả lời đầy đủ hơn.

Sự đổi mới của công nghệ này nằm ở khả năng trích xuất hiệu quả các phần quan trọng của thông tin, đặc biệt là trong các tài liệu dài hoặc văn bản chứa thông tin phức tạp, cho phép cung cấp thông tin chính xác hơn. Điều này cho phép người dùng truy cập thông tin mà họ tìm kiếm nhanh chóng và chính xác.

Ngoài ra, việc giới thiệu RAPTOR dự kiến sẽ cải thiện đáng kể độ chính xác và tốc độ của việc tìm kiếm thông tin so với các công nghệ thông thường. Đây sẽ là một lợi thế lớn, đặc biệt đối với các công ty và tổ chức nghiên cứu xử lý lượng dữ liệu lớn.

Nghiên cứu này đại diện cho một bước tiến quan trọng trong lĩnh vực tìm kiếm thông tin và dự kiến sẽ có nhiều ứng dụng hơn trong tương lai. Đối với một sinh viên chuyên ngành kỹ thuật thông tin, hiểu được công nghệ tiên tiến như vậy và khám phá tiềm năng của nó sẽ là một trải nghiệm rất có giá trị.

ーーー

<Claude 3 Sonnet>

Để tóm tắt nội dung của tệp PDF này, nó trình bày các điểm sau:

Công nghệ tìm kiếm và tóm tắt văn bản dài tiên tiến, RAPTOR, được giới thiệu. So với các phương pháp tìm kiếm truyền thống, nó có thể truy xuất chính xác thông tin liên quan hơn từ toàn bộ tài liệu, cải thiện đáng kể độ chính xác của các nhiệm vụ hỏi đáp.

Cụ thể, ba điểm sau đây là đổi mới:

Áp dụng phương pháp tìm kiếm hiệu quả xem xét cấu trúc phân cấp của tài liệu, cho phép trích xuất chính xác thông tin liên quan ngay cả từ các tài liệu dài và lớn.

Tóm tắt tự nhiên thông tin đã truy xuất, tạo ra các nút cấp cao có thể trả lời trực tiếp các câu hỏi.

Kết hợp với mô hình ngôn ngữ lớn GPT-4, đạt được độ chính xác cao trong việc hỏi đáp.

Các thí nghiệm đánh giá cho thấy độ chính xác của việc hỏi đáp trên tập dữ liệu NarrativeQA đã được cải thiện đáng kể so với các phương pháp truyền thống. Trong việc trích xuất thông tin và trả lời câu hỏi từ các tài liệu dài, RAPTOR đã đạt được những kết quả đột phá.

ーーー

Mặc dù tôi đã chỉ định “bằng tiếng Nhật”, nhưng Llama 3 đã phản hồi bằng tiếng Anh… Tuy nhiên, Llama 3 dường như có độ chi tiết kỹ thuật cao nhất. Có vẻ như Llama 3 và GPT-4 Turbo hòa, còn Claude 3 Sonnet đứng ở vị trí tiếp theo.

Tóm Tắt

Bài viết đã trở nên khá dài khi tôi thử nhiều điều khác nhau, nhưng để tóm tắt, đây là những ấn tượng của tôi:

- Groq nhanh…! Và rẻ…!

- Chatbot UI tiện lợi…!

- Mặc dù Llama 3 được đánh giá cao hơn Claude 3 Sonnet trong các bảng xếp hạng, tôi đánh giá là gần như tương đương. Tuy nhiên, điểm cộng tuyệt vời là nó được công bố dưới dạng mã nguồn mở…!