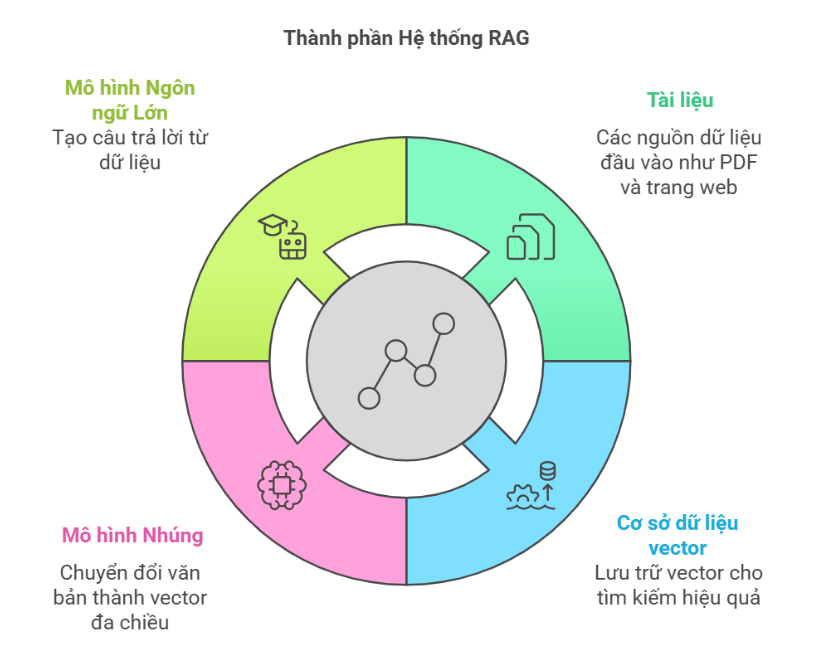

Trong vài năm trở lại đây, RAG (Retrieval-Augmented Generation) nổi lên như một giải pháp “cứu cánh” cho các hệ thống chatbot. Nếu chatbot...

We make services people love by the power of Gen AI.