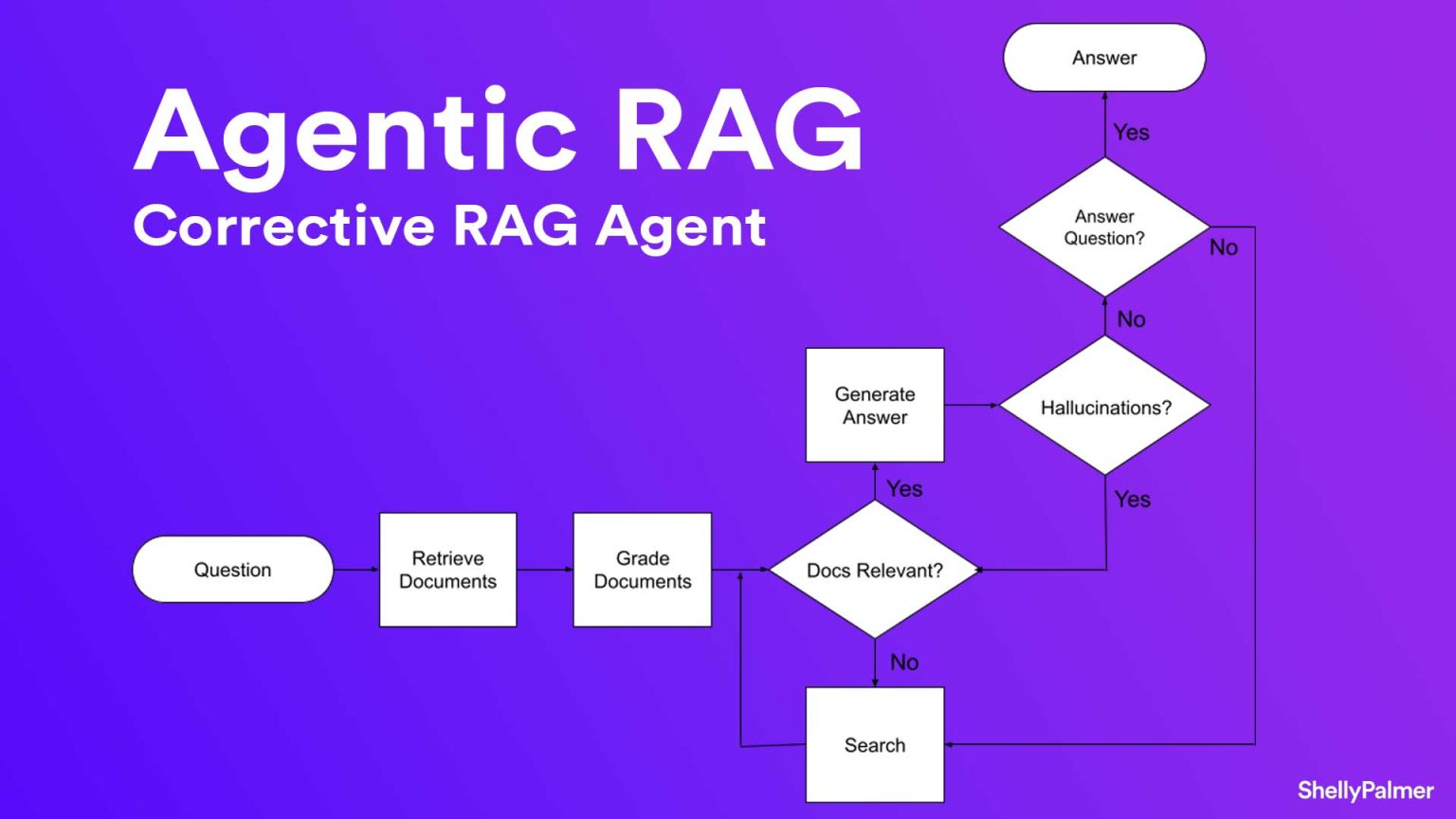

Agentic RAG là giải pháp truy xuất dữ liệu thông minh, kết hợp AI Agent để vượt qua hạn chế của RAG truyền thống,...

We make services people love by the power of Gen AI.