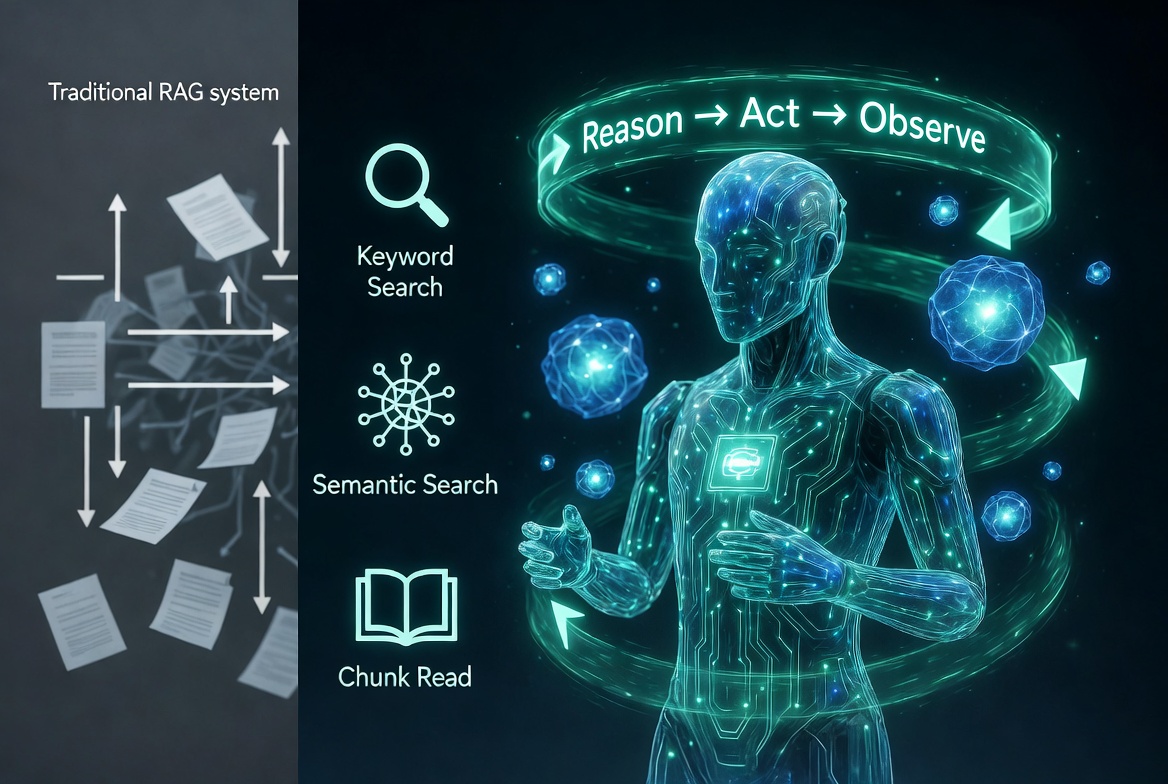

Trong thời đại AI phát triển nhanh chóng, Retrieval-Augmented Generation (RAG) đã trở thành giải pháp then chốt giúp các mô hình ngôn ngữ...

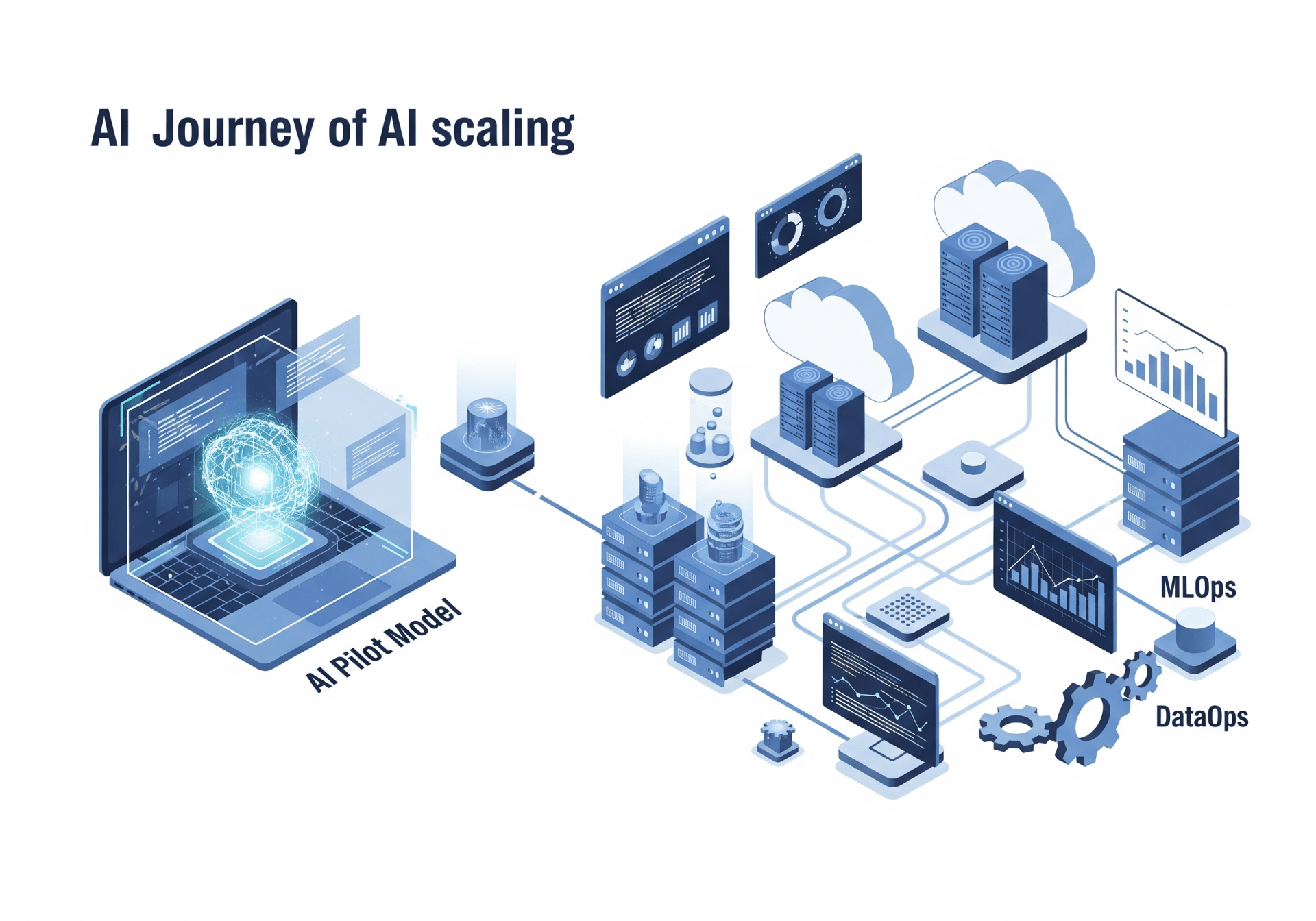

We make services people love by the power of Gen AI.