CLAUDE CODE PLUGIN Code-Simplifier Công cụ refactor và làm sạch code chính thức được phát triển bởi team Claude Code tại Anthropic Plugin này...

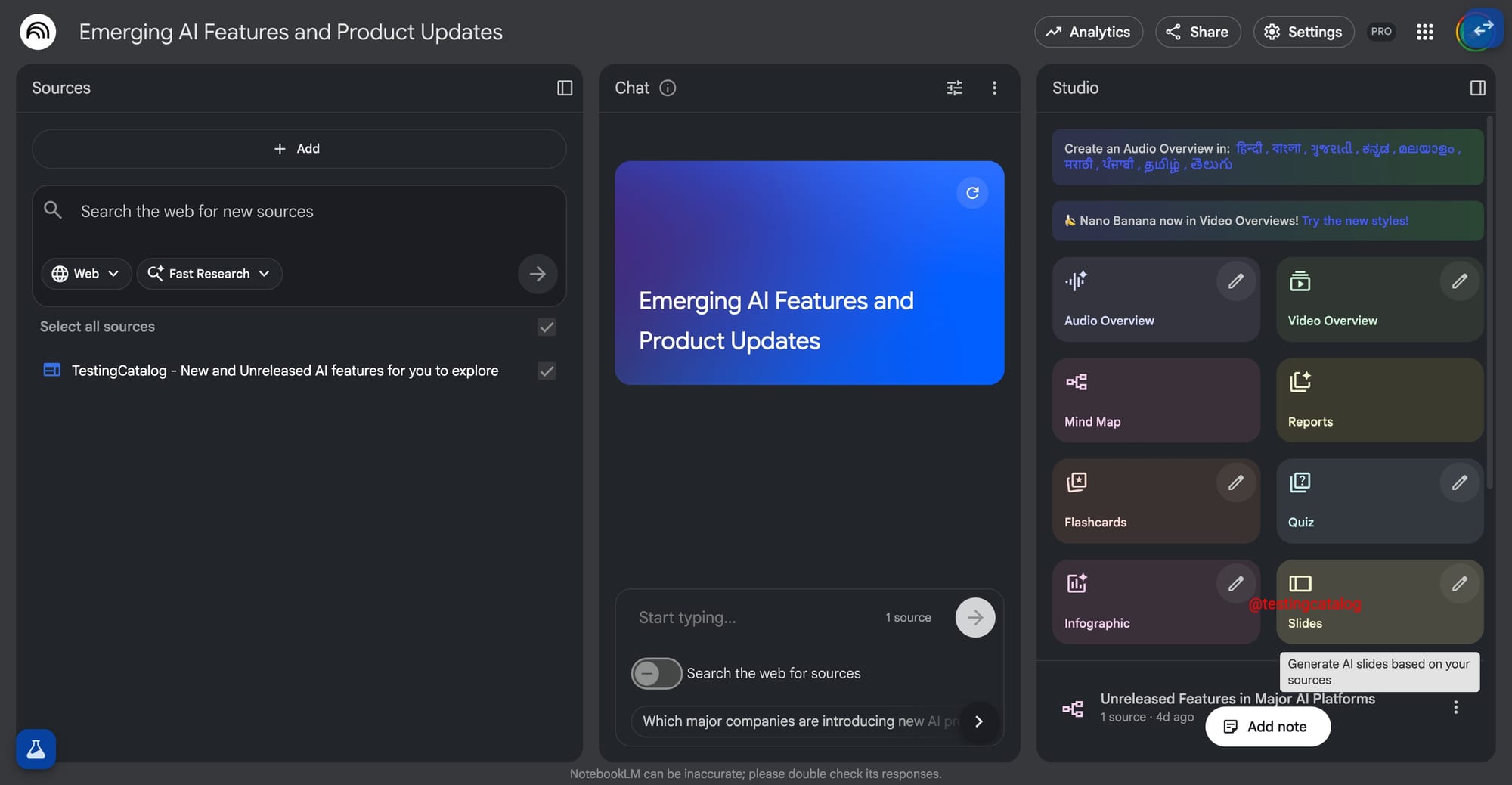

We make services people love by the power of Gen AI.