Tech outsourcing.

Fast and

Affordable.

Scuti JSC - Your reliable Japanese IT outsourcing company based in Vietnam that serves high standard market like Japan but at very affordable price.

Our offshore software development talents onboard quickly to jump-start your tech projects.

Have something in mind to work on?

We take pride in our extensive client base of 100+ satisfied companies.

Everything you need to deploy your Project.

Speed Up Deployment and Save on Costs.

We empower your project deployment from Concept to Completion.

Custom Software Development

Creating custom software tailored to your specific requirements, covering front-end and core back-end technologies.

QA & Testing

Secure your technology with careful manual and automated testing.

Chatgpt Integration

Enhance your product with seamless ChatGPT integration.

Mobile App Development

Develop high-performing, scalable, and secure mobile apps for iOS and Android devices.

Blockchain Development

Creating customized blockchain solutions tailored to your needs.

Software Maintenance

Maintaining your software in top performance with expert maintenance.

No worries. We Cover Your Tech Stack.

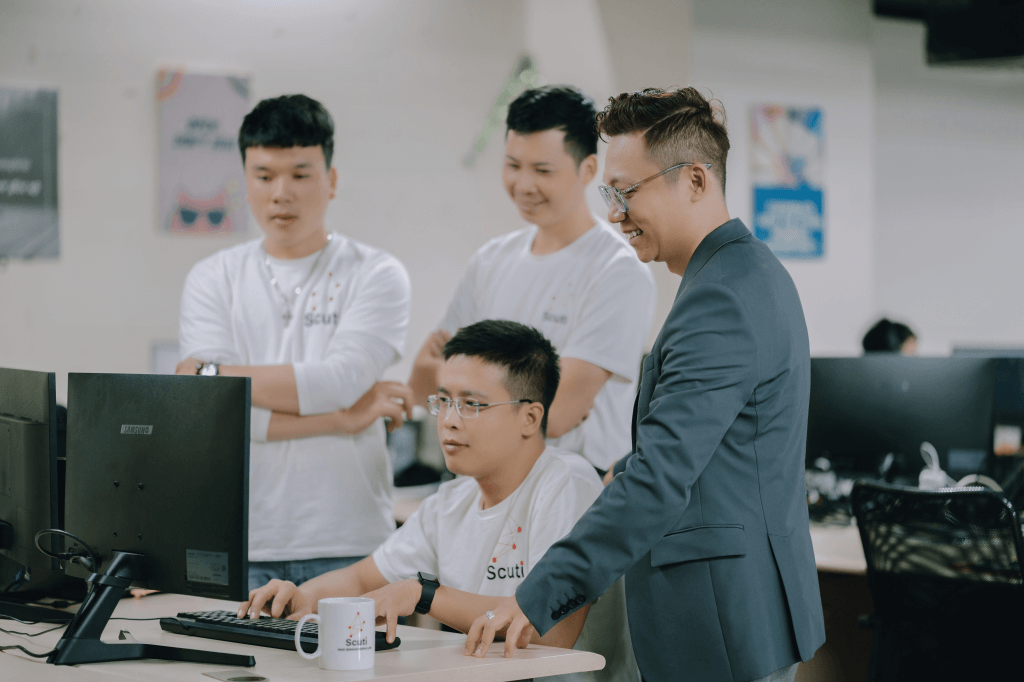

Our 100+ team has expertise in almost every top programming language.

Customer satisfaction is our North Star.

Make Services People Love.

“For our company, this is the first time developing software in the form of Offshore but it has achieved more than expected results. Thanks to Scuti, we were able to launch fan club site 5 times faster and have reduced costs by 30% compared to the initial estimation.”

Mr. Natsumi Takamura

Axel Entertainment Co., Ltd.

“Scuti have assembled a team of very highly skilled engineers, whose expertise is deemed rare to find in Japan, dedicated to developing proprietary systems, even for venture companies.”

Mr. Ryo Nagai

株式会社アールナイン(R09)

“Our collaboration with Scuti has surpassed our expectations and revolutionized our view of offshore development. Their partnership has become indispensable to our innovation-driven business, and we eagerly look forward to continuing our collaboration to mutually accelerate our growth in the future.”

Mr. Kota Takahashi

Axel Entertainment Co., Ltd.

Recognition and Achievements.

Awards and Certificates that Highlight Our Success.

Our working process.

Fast, Simple, Streamlined.

STEP 1

Join exploration call.

Let's discuss your business on a discovery call. We'll cover team structure, approach, success criteria, timeline, budget, and required skills to see how we can assist.

STEP 2

Discuss solution and team structure.

In a matter of days, we'll wrap up your project specifications, agree on how we'll proceed, and bring your team on board.

STEP 3

Get Started And Track Performance.

Once we agree on the goals, we'll start working right away. We'll keep track of progress, provide regular updates, and adapt to your changing needs.